IA Act : comment anticiper et décrypter les transformations à venir

Article écrit par Jérôme Lambert et Julie François-Franco

Introduction

Dans le paysage technologique en constante évolution, l'intelligence artificielle (IA) s'impose comme un acteur majeur, révolutionnant la manière dont les entreprises fonctionnent et interagissent avec leurs clients et à termes comment certains salariés travailleront. Cependant, avec cette grande puissance vient une responsabilité tout aussi grande. L'Union européenne, en reconnaissant cette réalité, a présenté l'IA Act, un cadre réglementaire destiné à guider les entreprises vers une utilisation éthique et sûre de l’IA. Si vous êtes dirigeant ou manager, il est essentiel de comprendre ce que cela signifie pour votre entreprise. Dans cet article, nous allons décortiquer les contours de ce règlement, en mettant l'accent sur ce que chaque décideur doit savoir pour naviguer sereinement dans ce nouveau cadre juridique venant compléter les réglementations existantes en droit du numérique. L'objectif principal de cet article est de vous fournir un éclairage clair sur la réglementation à venir qu'est l'IA Act. Il est crucial de reconnaître que cette réglementation, loin d'être une simple recommandation, s'imposera bientôt à nous et aura des conséquences tangibles sur la manière dont nous opérons et intégrons l'IA dans nos activités. Ignorer cette réalité pourrait conduire à des répercussions majeures, tandis qu'une compréhension et une préparation adéquates pourraient offrir un avantage compétitif. L'intention ici n'est pas seulement d'informer, mais d'inciter chaque dirigeant et manager à appréhender, réfléchir et agir en anticipant les impacts de l'IA Act sur son organisation. Car comprendre, c'est avant tout être en mesure de s'adapter et d'innover en toute conformité. Notre article se découpera en deux parties:

- La première partie se penchera sur les risques intrinsèques associés à l'IA et soulignera la nécessité impérieuse d'établir des principes forts, à savoir un cadre qui garantit non seulement l'utilisation éthique de l'IA, mais aussi sa conformité face aux défis sociétaux et réglementaires.

- La seconde partie mettra en lumière l'importance cruciale d'ancrer une culture à la fois technologique et juridique au sein des organisations. Dans un monde où la technologie et la loi s'entremêlent de plus en plus, comprendre leurs interactions devient un impératif pour toute organisation.

Le fil rouge de notre exploration sera d'anticiper et de décrypter les transformations à venir, afin de mieux préparer les dirigeants et managers à l'impact inévitable de l'IA Act dans le monde des affaires.

Qu’est ce que l’IA Act ?

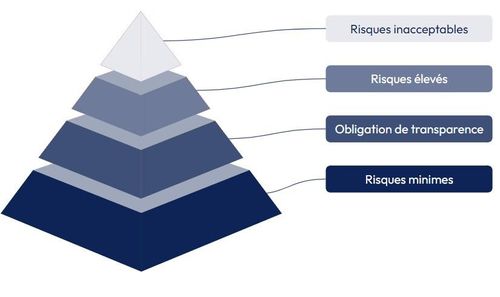

L'IA Act, initiative phare de la Commission européenne, vise à trouver un équilibre entre la nécessaire réglementation et le soutien à l'innovation technologique. Selon la lettre du règlement, seuls les modèles d'IA pour lesquels la Commission anticipe qu'ils pourraient présenter des risques élevés pour les droits et libertés des personnes sont régulés. C’est une approche fondée sur les risques et illustrée par une "pyramide des risques" (allant d’inacceptable à minimes), où les niveaux inférieurs—risques minimes et modérés—seraient régis par de simples codes de conduite.

Les piliers de l’IA Act

L'IA Act repose sur trois piliers fondamentaux: mettre en place des garde-fous robustes, établir une gouvernance solide et diriger l'innovation de manière responsable. L'objectif est double : d'une part, garantir que les systèmes d'IA déployés dans l'Espace numérique européen soient conformes aux droits fondamentaux et aux valeurs de l'UE, pour rassurer le public, et d'autre part, offrir une sécurité juridique qui encouragerait les investissements et l'innovation dans le domaine de l'IA, pour rassurer les acteurs. Le texte réglementaire envisage un marché unique pour des applications d'IA qui seraient légales, sûres et fiables, en évitant ainsi la fragmentation du marché intérieur en l’absence de réglementation et de contrôle. La régulation du marché et l’avènement de l’IA Act ont été rendus urgents par la sortie prématurée des Intelligences Artificielles Génératives (IAG) parfois appelés modèles de fondation, et leur prise en main par le grand public. Ce texte dans son approche philosophique se concentre sur les risques que les modèles font peser sur les personnes et non sur les risques que les technologies utilisées font peser sur les personnes. Pour preuve, un même modèle de données peut se voir encouragé ou sévèrement régulé en fonction de son application et des risques potentiels qu'il présente pour les citoyens. Ainsi, les systèmes d'identification biométrique (SIB) ou de reconnaissance faciale sont strictement contrôlés lorsqu'ils entraînent une surveillance de masse comme dans les cas de la lutte contre le terrorisme ou la criminalité. En contraste, leur utilisation est encouragée dans le domaine de la recherche médicale, où ils contribuent au traitement et au suivi des maladies.

La pyramide des risques

Les risques minimes

Si la base de la pyramide n’entraîne pas d’obligations particulières, la Commission européenne ainsi que le Conseil de l'Europe incitent à l’élaboration de codes de conduite (à la discrétion des entreprises) afin d’encourager l'adhésion volontaire aux bonnes pratiques pour le développement et l’utilisation de systèmes d'IA jugés à risque faible. Les entités commerciales ou les autorités publiques qui développent ou déploient des technologies d'IA non considérées comme à haut risque et uniquement tenues de respecter des exigences d'information de base pourraient opter pour une démarche collective en adoptant un code de conduite commun. Ce faisant, elles s'engagent à respecter les normes adéquates pour garantir la fiabilité de leurs systèmes d'IA. Il est nécessaire d’attendre la mise en œuvre et l’appropriation du règlement par les professionnels pour connaître précisément les pratiques en matière de codes de conduite.

Les risques modérés

Pour les risques modérés, il est important de communiquer aux individus qu'ils sont en train d'interagir avec une IA, “à moins que cela ne soit évident en raison des circonstances et du contexte d’utilisation” (extrait du règlement). Les utilisateurs doivent être informés lorsqu'ils sont soumis à des systèmes d'analyse émotionnelle ou de classification biométrique. Les contenus générés par des techniques dites de deepfake doivent être clairement étiquetés comme tels, sauf dans les cas où leur utilisation est justifiée par l'exercice de droits ou libertés essentiels ou pour des motifs d'intérêt général.

Les risques élevés

Dans le cas des modèles d’IA identifiés comme à haut risque, les principes spécifiques de l'IA Act s'appliqueront. Le code de conduite n’étant pas applicable ici. Les contraintes apposées aux systèmes reconnus à hauts risques seront plus fortes, essentiellement utilisées dans des domaines identifiés comme à risque. La Commission européenne a établi une liste de huit catégories d'intelligences artificielles (IA) considérées comme à haut risque. Cette liste, qui pourra évoluer, vise à garantir que ces technologies soient développées et utilisées de manière responsable et éthique. Les catégories d'IA à haut risque comprennent :

- La reconnaissance biométrique à distance en temps réel : utilisée pour identifier les individus à distance, par exemple pour la surveillance ou le contrôle des frontières,

- Les systèmes d'évaluation et de notation utilisés pour le recrutement, la sélection, la promotion et le licenciement de personnel,

- L'IA dans la justice prédictive et les autorités répressives : utilisée pour prédire la criminalité et pour la prise de décision dans le système judiciaire,

- L'IA dans les systèmes de contrôle social et de notation de crédit : utilisée pour évaluer la fiabilité et la solvabilité des individus,

- L'IA dans les systèmes de jeux d'argent et de paris : utilisée pour influencer le comportement des joueurs,

- L'IA dans les robots autonomes : utilisés pour des tâches dangereuses ou critiques, par exemple dans l'industrie ou la médecine,

- L'IA dans les deepfakes et la désinformation : utilisée pour créer de faux contenus ou pour manipuler l'opinion publique,

- L'IA dans les systèmes d'éducation et de formation : utilisée pour l'apprentissage et l'évaluation des élèves.

Pour qu'un système d'IA à haut risque puisse être commercialisé, un marquage CE fourni par le fournisseur, indiquant sa conformité aux normes de l'Union européenne devra être apposé. Le fournisseur devra effectuer plusieurs étapes :

- Vérifier le classement du produit comme à haut risque,

- Assurer que la conception et le développement respectent les exigences du règlement sur l'IA,

- Évaluer et documenter cette conformité.

La mise sur le marché, ou mise en service, ne pourra se faire qu’après avoir apposé le marquage CE et signé la déclaration de conformité. Le marquage CE est une déclaration du fabricant attestant que le produit respecte les réglementations nécessaires pour circuler librement sur le marché européen. Il est impératif pour les produits régis par une législation spécifique, comme l'IA Act, de porter ce marquage. Nous voyons dans ce marquage CE un risque pour les utilisateurs et consommateurs d’IA. Les concepteurs deviennent ainsi juge et partie dans le fait qu’ils déclarent eux-mêmes respecter la réglementation. Les fournisseurs (“une personne physique ou morale, une autorité publique, une agence ou tout autre organisme qui développe ou fait développer un système d’IA en vue de le mettre sur le marché ou de le mettre en service sous son propre nom ou sa propre marque, à titre onéreux ou gratuit”, issu du règlement) doivent aussi mettre en place une gestion des risques, utiliser des données de haute qualité pour l'entraînement, assurer la traçabilité et l'auditabilité du système, fournir une documentation aux utilisateurs sur l'utilisation du système, instaurer une supervision humaine, et garantir la robustesse, la précision et la cybersécurité du produit. Le règlement s'applique à de nombreux domaines, tels que l'identification biométrique, la catégorisation des individus, la gestion d'infrastructures critiques, l'éducation, les ressources humaines (=management algorithmique), les contrôles aux frontières, ainsi que le secteur gouvernemental et judiciaire, incluant la maintenance des processus démocratiques et l'application des lois.

Les risques inacceptables

Même s’il est impossible d’anticiper tous les usages qui seront faits par les intelligences artificielles, la Commission européenne, soutenue par le Parlement européen a défini des pratiques jugées comme interdites. Cette interdiction s’applique à tous les systèmes d'IA qui sont développés, utilisés ou commercialisés dans l'Union européenne, quelle que soit la nationalité des personnes qui les utilisent ou les développent. Ce sont les usages des systèmes d'IA qui feraient peser des risques inacceptables sur les personnes en violation de leurs droits fondamentaux. On peut citer notamment, toutes les pratiques ayant trait à la manipulation des personnes vulnérables - les enfants ou les personnes en situation de handicap - pouvant entraîner un préjudice psychologique ou physique.

Les manipulations affectant les adultes pourraient être réglementées par des lois existantes concernant la protection des données, la consommation et les services numériques, qui s'assurent de l'information et du consentement éclairé des individus concernant le profilage et d'autres pratiques qui influencent leur comportement. De plus, la proposition de règlement interdit le système de notation sociale par IA utilisé par les autorités publiques, ainsi que l'utilisation de l'identification biométrique en temps réel dans des espaces publics à des fins de surveillance, à l'exception de circonstances exceptionnelles et spécifiques.

Qu’est ce que cela signifie pour vous ?

Besoin d’une culture juridique au sein des équipes data

L’apparition des réglementations strictes telles que le RGPD (Règlement Général sur la Protection des Données) et l'IA Act, nécessitent que les professionnels de la donnée (data analyst, data scientist, data engineer…) possèdent une culture juridique pour l’exercice de leur métier. Cette exigence ne relève pas seulement de la conformité aux cadres légaux complexes et en constante évolution, mais aussi de la nécessité d'une intégration éthique et responsable de l'IA dans la société. Une compréhension des implications juridiques permet aux professionnels de la data de naviguer avec assurance dans le paysage réglementaire, assurant ainsi que les données sont traitées de manière éthique, que la vie privée des utilisateurs est respectée et que les systèmes d'IA sont conçus et déployés de façon à prévenir la discrimination et à protéger les droits fondamentaux. La culture juridique des équipes data permet d’anticiper les risques légaux potentiels, pour gérer la responsabilité et pour instaurer des pratiques de gouvernance des données robustes qui respectent les différents règlements (RGPD et IA Act). En outre, une telle culture permet de construire la confiance des utilisateurs et des consommateurs, devenant ainsi un avantage concurrentiel dans un marché où la confiance dans les pratiques de gestion des données et l'utilisation des systèmes d'IA est de plus en plus scrutée par le public et les régulateurs.

Pour la création d’un référent IA Act dans les équipes data

Avec l’adoption de l'IA Act, nous pensons qu’un référent IA Act doit intégrer chaque équipe manipulant de la donnée. Ce référent IA Act devient un maillon essentiel, assurant que les projets d'IA soient conçus, développés et déployés conformément à un cadre réglementaire rigoureux qui met l'accent sur les risques, la conformité et la protection des droits individuels. La présence d'un tel expert au sein des équipes garantit une veille réglementaire continue, permettant à l'entreprise de rester à jour avec les dernières obligations légales et d'ajuster rapidement ses pratiques en cas de changements législatifs. De plus, le référent IA Act agit en tant que conseiller stratégique, en assurant que les innovations en IA s'alignent sur les principes éthiques et les standards de gouvernance requis, et en minimisant ainsi les risques de non-conformité qui pourraient entraîner des sanctions conséquentes, des atteintes à la réputation et des perturbations opérationnelles. Dans le domaine spécifique des données, où le traitement et l'analyse se font à l'échelle de grandes quantités et à une vitesse sans précédent, l'intégration d'un référent IA Act dans les équipes data devient tout aussi critique. Ce professionnel assure que la collecte, le stockage, l'utilisation et l'échange de données sont réalisés dans les limites de ce que le RGPD et l'IA Act permettent, tout en veillant à ce que les méthodes d'analyse prédictive et les algorithmes d'apprentissage automatique n'enfreignent pas les droits fondamentaux. Il apporte également son expertise dans l'évaluation d'impact relative à la protection des données (EIPD) spécifique aux systèmes d'IA, un processus obligatoire pour les applications à haut risque. Ainsi, le référent peut guider les équipes data dans la navigation entre l'innovation et la conformité, assurant une exploitation des données éthique et juridiquement viable, tout en contribuant à instaurer une culture de responsabilité et de transparence au sein de l'entreprise. En somme, le référent IA Act devient un pilier central pour que les entreprises exploitent le potentiel de l'IA tout en respectant les principes démocratiques fondamentaux et en préservant la confiance des parties prenantes.

Conclusion

Le 2 février 2024, le Conseil de l’Union européenne a adopté l’IA Act. Cette version du texte doit maintenant être approuvée par le Conseil européen et le Parlement européen. Nos recommendations pour les dirigeants et managers sont les suivantes :

- Tout comme le RGPD s’est imposé à nous, ne nagez pas à contre-courant : imprégnez-vous de la réglementation, lisez-là comme une opportunité

- L’IA Act représente une opportunité pour former les équipes data aux enjeux, aux contrôles qui doivent être mis en place dans les algorithmes

- L’IA Act représente une opportunité pour mettre en place une gouvernance des algorithmes produits et ainsi être leader dans les processus de respect de la réglementation

- L’IA Act représente une opportunité d’innovation dans des règles définies

- L’IA Act représente une opportunité de croisement des compétences entre les ingénieurs data et les spécialistes du droit. Cette opportunité doit, selon nous, se concrétiser par la nomination de référents IA Act au sein des équipes data