Faire confiance : Réinventer l'expérience utilisateur à l'ère l’IA

Intro - Du résultat à la relation, quand l’IA change les règles de la confiance

Depuis deux décennies, les expériences utilisateur se construisent sur une équation assez simple : fiabilité technique + clarté de la proposition de valeur = adoption. Spotify me recommande une musique, Citymapper me dit de monter dans ce bus : tant que le service est fluide, je ne m’interroge pas vraiment sur ce qu’il se passe en coulisses. L’algorithme reste invisible, seul le résultat compte.

Mais avec l’arrivée des agents conversationnels dopés à l’IA, les lignes bougent. Quand un agent résume une réunion ou rédige un discours à ma place, je n’accepte plus seulement le résultat : j’attends des explications, des justifications. L’IA n’est plus un moteur caché derrière des résultats finaux, c’est un interlocuteur qui co-décide et co-créé avec moi, en temps réel. Une vulnérabilité inédite apparaît alors : j’accepte qu’une partie de mes idées et de mes décisions dépende désormais d’un système opaque, avec lequel j’entretiens une relation de confiance.

Ces changements que j'entrevois changent profondément la nature des produits que je conçois en tant que designer ; je ne construis plus seulement des interfaces efficaces, mais aussi une relation. Les designers et concepteurs de produit plus largement portent alors une nouvelle responsabilité, qui dépasse l’ergonomie des interfaces : celle de construire des produits intégrant l'IA dignes de confiance.

Tous les concepts proposés dans cet article sont résumés sous forme de matrices pour diagnostiquer et construire la confiance au sein de vos produits en suivant ce lien. |

|---|

1. Définir la confiance à l’ère de l’IA

La confiance, dans le champ des HCI (Human Computer Interface), c’est accepter de se rendre un peu vulnérable, parce que la contrepartie semble en valoir la peine. Concrètement : en tant qu’utilisatrice ou utilisateur, c’est renoncer à tout contrôler parce que j’estime que le produit va m’aider, même si je ne peux pas en avoir la preuve à priori.

La littérature sur la confiance[1] identifie généralement trois piliers pour comprendre cette relation : la compétence (le produit délivre le résultat attendu), la bienveillance (il agit dans l’intérêt de l’utilisateur), et l’intégrité (il est prévisible, ne trahit pas ses engagements, explicites ou implicites). Tant que ces trois piliers tiennent, la relation fonctionne.

Mais avec l’IA générative, ce modèle se fissure, parce que les modèles sont profondément imprévisibles : les hallucinations sont difficiles à anticiper et les logiques de décision restent largement opaques. La confiance ne se joue alors plus seulement sur « le résultat est-il bon ? », mais sur la qualité de la relation continue entre l’utilisateur et l’IA. Elle passe du domaine fonctionnel au domaine profondément relationnel.

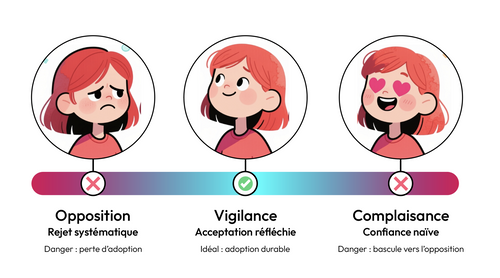

2. Les trois attitudes face à l'IA : du rejet à la complaisance

La confiance, ce n’est pas binaire. C’est un spectre dynamique, sur lequel je me déplace en fonction du contexte, du produit, de mon expérience et du coût perçu d’une erreur.

Face à une IA, trois attitudes émergent[2] :

L’opposition : le rejet systématique, "Je n'utiliserai jamais ça."

C’est la défiance absolue. Je rejette la co-création avec l’IA, je refuse d'accepter cette vulnérabilité et je préfère garder le contrôle total, quitte à passer à côté de gains potentiels de productivité ou de qualité. Cette attitude n’est pas irrationnelle : elle me protège d’un système opaque dont je ne veux pas dépendre, mais elle me ferme aussi des portes.

La vigilance : l'acceptation réfléchie (l'idéal), "Je vais essayer, mais je surveille."

J’accepte la co-création, mais je garde mon esprit critique : je teste, je pose des questions, je demande « Pourquoi tu me proposes ça ? », je calibre ma confiance en fonction de ce que j’observe. C’est l’état qu’on cherche à créer en tant que conceptrice ou concepteur de produits : un usage réel, critique, qui se construit et se maintient dans le temps.

La complaisance : la confiance naïve, "L'IA sait mieux que moi."

J’abdique mon jugement critique et je prends pour argent comptant ce que l’IA propose, sans vérifier. À court terme, je gagne du temps ; mais cette posture est risquée : un seul faux pas (une hallucination prise comme vraie, une image trompeuse, une info erronée) peut me faire basculer d’un coup vers l’opposition, en emportant la crédibilité du produit (et parfois ma crédibilité vis à vis des autres) avec elle.

3. Confiance et IA : les nouveaux points de friction

Qu’est-ce qui me pousse à basculer vers l'opposition ou la complaisance lorsque je co-crée avec l’IA ? Qu’est-ce qui me pousse à fermer ChatGPT à la première erreur lors de la rédaction d’un e-mail ?

La réponse se trouve dans un changement fondamental : avant l'IA générative, les algorithmes étaient passifs, invisibles. Netflix me recommandait un film, je regardais ou j’ignorais ; Google Maps me proposait un itinéraire, je l’acceptais ou non. Il n’était pas question de dialoguer avec le produit pour lui demander des explications, des justifications, des ajustements.

Avec l’IA générative, l’algorithme devient visible, actif. Il « parle » avec moi, « attend » mes retours et ajuste son « comportement ». L’IA devient un agent de l'interface et cette présence crée des points de friction, c’est à dire des endroits où je dois accepter de perdre un peu de contrôle. Et quand ces frictions ne sont pas adressées, c’est là que la confiance se fissure.

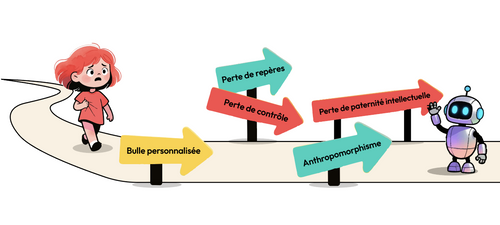

Quelques points clés à considérer pour identifier les frictions de confiance au sein des produits IA :

Bulle personnalisée : plus un système apprend mes habitudes, plus il peut optimiser son comportement à partir de mon historique. C'est confortable jusqu'au moment où ça devient étouffant, comme lorsque Netflix insiste sur le même type de contenus alors que je cherche à explorer autre chose. À ce moment-là, la confiance s’effondre.

Anthropomorphisme : une interface qui « comprend » le langage naturel donne l’impression de comprendre aussi mes intentions. Le jour où je découvre que la réponse ne vient pas d’une véritable compréhension, mais d’une construction statistique, la confiance craque et la relation se brise.

Perte de repères : à force d’hyper-personnalisation, un système qui se comporte différemment selon le contexte (historique, heure, type de requête) peut affaiblir la prévisibilité. Si tout change trop souvent, je ne peux plus me construire un modèle mental stable. Sans ce contrôle cognitif, la confiance s’érode.

Perte de contrôle : dès que l’IA agit directement (bloquer un créneau, envoyer un email, etc), je me retrouve responsable de décisions que je n’ai pas vraiment prises moi-même. Accepter que quelque chose soit fait en mon nom demande une confiance extrême.

Flou sur la paternité intellectuelle : lorsque l’IA et moi co-concevons, il devient difficile de tracer qui est auteur de quoi. Cette fluidité peut être créative, mais aussi déstabilisante : je ne sais plus toujours ce qui vient vraiment de moi.

L’IA m’invite progressivement à abandonner du contrôle, de la compréhension, de la paternité intellectuelle… Dans ce contexte, le maintien de la confiance devient un prérequis à l’adoption du produit. La littérature[1][2] montre que la confiance ne peut être maintenue que si ces 3 conditions sont maintenues en permanence :

1. La contrepartie est clairement bénéfique (gain de temps, d'efficacité, d'expertise, de qualité, etc.) et doit être quelque chose que je ne pourrais pas obtenir seule ou facilement.

2. Je peux mesurer le comportement du système (transparence, explications, feedback visible, etc.), pour éviter l’effet “boîte noire”

3. Je peux intervenir si quelque chose dévie (erreur, mauvaise orientation, etc.) pour ne pas devenir prisonnier d'une décision que je ne contrôle pas.

Les équipes produits (Designers, PM, Ingénieurs) intégrant l’IA ont donc pour mission de créer les conditions d’un maintien de la confiance malgré ces zones de friction, en intégrant de manière fine des signaux de confiance forts, continus et visibles.

4. Cadrer et concevoir la confiance : une méthode en deux temps

Fort de ces enseignements, comment construire une interface intégrant l’IA tout en maintenant l’utilisateur dans une posture de vigilance, seul état garantissant une confiance durable ? On peut procéder en deux temps : cadrer correctement (se poser les bonnes questions) puis concevoir les bons mécanismes à implémenter, qui signalent à l’utilisateur que le produit est digne de confiance.

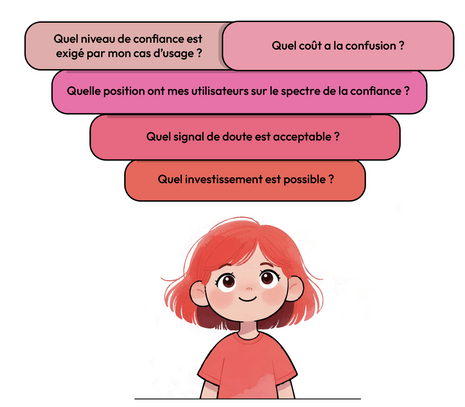

4.1 Cadrer : les questions à se poser

La confiance ne doit pas se penser comme un « one size fits all » : elle doit être dimensionnée sur mesure, en fonction de la criticité des cas d’usage couverts par le produit, du profil des utilisateurs et des ressources disponibles. Pour calibrer la bonne stratégie d’implémentation, il s’agit de définir le juste niveau de confiance requis au sein du produit. Les questions ci-dessous sont des exemples de thématiques pour cadrer le sujet.

1. Quel est le niveau de confiance exigé par mon cas d’usage ?

Une recommandation de contenu (une musique, un film) n’a pas les mêmes enjeux qu’une aide à la décision médicale ou un virement bancaire. Le coût d’une erreur ne se mesure pas de la même manière. Plus le niveau de confiance demandé est élevé, plus la conception doit être robuste.

2. Où se situe mon utilisateur sur le spectre de confiance ?

Une même personne peut être en opposition sur un produit, en vigilance sur un autre et en complaisance sur un troisième. Observer les comportements in situ (les questions que la personne se pose, les vérifications qu’elle met en place ou non, etc.) permet de positionner les personas sur ce spectre et concevoir en conséquence.

3. Quel est le coût de la confusion entre ce que l’IA peut faire et ce que l’utilisateur croit qu’elle peut faire ?

Surestimer les capacités de l’IA peut au mieux faire perdre du temps, au pire engendrer des décisions risquées. L’enjeu est d’identifier si ce coût est faible (l’utilisateur croit que l’IA peut faire quelque chose, se rend compte que non, puis réessaye) ou élevé (l’utilisateur croit que l’IA peut faire quelque chose, et cette confusion génère une erreur métier critique).

4. Quel est mon signal de doute acceptable ?

L’IA se trompera. La question n’est pas « comment éviter toute erreur », mais « à quel niveau de doute doit-on ralentir, alerter et redonner clairement la main à l’utilisateur ? ».

5. Quel investissement suis-je prêt à mettre en place pour construire cette confiance ?

Afficher plus d’informations, concevoir des mécanismes d’explicabilité, de traçabilité, ou de contrôle a un coût cognitif (pour l’utilisateur) et financier (coût de développement). L’enjeu est de définir un investissement raisonnable dans le socle de confiance entre utilisateur et produit.

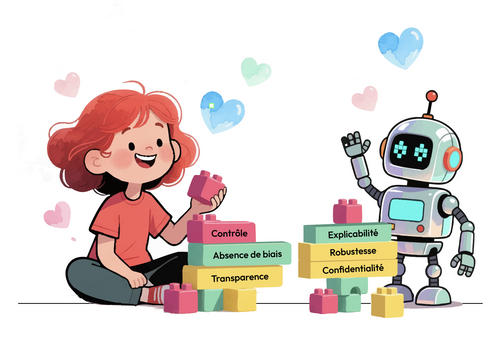

4.2 Concevoir : leviers et signaux de confiance à mettre en place

Une fois le diagnostic posé (niveau de risque, profil utilisateurs, budget disponible, etc.), reste à traduire ces choix en signaux concrets dans l'interface. Quels éléments vont incarner cette relation de confiance ? Les travaux récents sur « la Trustworthy AI »[3] identifient six leviers qui peuvent servir de boîte à outils pour les designers et les équipes produit.

| Levier | Enjeu | Antipattern | La question à se poser | Signaux de confiance possibles à mettre en place |

|---|---|---|---|---|

| #### Contrôle humain | Je garde la main, l’IA m’assiste mais ne me remplace pas | “Je ne peux rien faire. L'IA décide pour moi” | Dans quelles situations l’utilisateur doit-il pouvoir reprendre la main immédiatement ? | - Suggestions toujours éditables (texte grisé, sidebar, boutons « Appliquer » / « Modifier ») - Boutons Annuler / Arrêter visibles après chaque action automatique - Paramètres pour choisir ce que l’IA peut faire seule ou non |

| #### Absence de biais | l’IA ne doit pas discriminer systématiquement certains profils ou groupes d’utilisateurs | "L'IA discrimine ou traite injustement certains groupes" | Comment montrer à l’utilisateur que la décision ne repose pas sur des critères biaisés ? | - Audit des données d’entraînement et test du modèle sur des populations diverses. - Explication des critères utilisés pour certains choix - Options pour limiter l’usage de certaines données (à l’image des modes “incognito” sur les navigateurs) |

| #### Explicabilité | Je comprends ce que l’IA fait et pourquoi | "Je ne sais pas pourquoi l'IA a choisi ça, c’est une boite noire" | En [X] secondes, que doit comprendre l’utilisateur sur la façon dont l’IA a décidé ? | - Messages courts de type « Vous voyez ceci parce que… » - Mise en avant des sources ou facteurs principaux de la décision - Indication explicite des limites ou zones d’incertitude |

| #### Robustesse & Précision | L’IA a un niveau de fiabilité suffisant, y compris dans les situations inattendues | "L'IA se trompe. Je ne peux pas m'y fier" | Que se passe-t-il concrètement quand l’IA n’est pas sûre d’elle ? | - Langage nuancé quand la confiance est faible (« hypothèse », « piste probable »). - Indicateur de confiance visible (ex. jauge ou label de fiabilité) - Fallbacks : passage à un humain, demande d’infos supplémentaires, lien vers les sources |

| #### Confidentialité & Sécurité | Je sais où vont mes données, et je garde la main dessus | "Où vont mes données ? Qui peut les voir ? Qu’est ce qui est conservé ?" | L’utilisateur peut-il facilement comprendre comment ses données sont utilisées ? | - Bandeau ou badge permanent expliquant le traitement des données (« Non utilisé pour entraîner nos modèles », durée de conservation, etc.) - Masquage automatique des données sensibles avant envoi - Paramètres simples pour choisir ce qui est conservé ou non |

| #### Responsabilité | Clarifier qui porte la responsabilité des décisions et offrir des recours | "Ce n’est la faute de personne, c’est juste l’IA” | Si quelque chose se passe mal, que peut faire concrètement l’utilisateur, et en combien de clics ? | - Lien « Signaler un problème » sous chaque génération pour corriger ou modifier - Journal d’activité indiquant qui a fait quoi (IA, utilisateur, tierce personne) et quand - Feedback visible sur la prise en compte du signalement (ex. escalade à un support humain) |

Conclusion : La confiance, nouvelle métrique de succès

Avec l'IA co-créative, la confiance devient une variable centrale à l’adoption au succès des produits.

Le paradigme de conception évolue : on ne conçoit plus seulement des écrans, mais une relation continue entre un utilisateur et un système qui parle, propose, agit à sa place.

Dans ce contexte, viser une « confiance totale » n’a pas de sens. Ce qui compte, c’est d’installer et de maintenir une vigilance sereine, où l’utilisateur accepte de déléguer, mais conserve son esprit critique et sa capacité à reprendre la main.

Concrètement, cela change trois choses pour les équipes produit et design :

- On ne peut plus traiter la confiance comme une « feature » à la marge : elle devient un critère de succès des produits intégrant l’IA.

- Chaque interaction avec l’IA doit être pensée comme un moment où l’utilisateur évalue le rapport entre bénéfice (gain de temps, de qualité, d’expertise) et vulnérabilité (perte de contrôle, d’explicabilité, de paternité). Pour y parvenir, la méthode se déroule en deux temps: cadrer le niveau de confiance nécessaire, puis prouver à l’utilisateur que le produit est digne de confiance, via des signaux concrets au sein de l'interface.

- Les métriques de succès doivent évoluer : mesurer seulement les usages ne suffit plus, il faut aussi mesurer la capacité des utilisateurs à questionner l’IA, à contester, à reprendre le contrôle, sans basculer dans la défiance ni dans la complaisance. Il revient alors aux équipes produit d’inventer les métriques de demain pour mesurer cette vigilance : non pas seulement « est-ce que l’IA est utilisée ? » mais « est-ce que la confiance que l'utilisateur accorde au produit est ajustée et durable ? »

Sources :

[1] Les piliers de la confiance ont été théorisés par Mayer, qui définit le modèle fondateur de la confiance (Ability, Integrity, Benevolence). Cette théorie à été à de multiples reprises adaptés au champ de l’UX, notamment par le NN Group.

[2] Des travaux sur le"calibrage de la confiance" ont montré que la confiance peut être sous-calibrée (Opposition) ou sur-calibrée (Complaisance). La “Vigilance" est l'état d'équilibre idéal, car pérenne. La confiance est également un spectre dynamique, nourri par les outcomes d’un produit.

[3] ”Establishing and evaluating trustworthy AI: overview and research challenges” est une synthèse récente qui transforme les directives éthiques (comme l'AI Act européen) en requirements techniques et design opérationnels. Elle valide scientifiquement la liste des 6 piliers (Human agency, Fairness, Transparency, etc.) comme étant le standard actuel pour passer de la théorie à la pratique de la confiance en IA.

Pour aller plus loin :

- Le High-Level Expert Group on AI (AI HLEG) de l'Union Européenne a repris les concepts militaires de “in the loop/on the loop/out of the loop” pour les appliquer à l'éthique de l'IA civile dans ses "Ethics Guidelines for Trustworthy AI". Ils insistent sur la notion de "Human-in-command" (ou Human Agency) comme principe éthique supérieur et standards de design pour garantir la souveraineté humaine.

- Quelques échelles scientifiquement validées pour la mesure de la confiance au sein d’un produit