Et si l'IA cassait Internet ? Comment les agents transforment la navigation web et son modèle économique

Imaginez que vous avez un problème avec le portable que vous venez d’acheter. Vous ouvrez votre assistant IA préféré et lui demandez si vous pouvez l’échanger. Votre assistant sait où vous avez acheté votre portable - c’est lui qui l’a fait. Il vérifie via une photo que le portable n’est pas endommagé ; vérifie les conditions de retour du vendeur ; vérifie que vous les remplissez bien et vous annonce que vous êtes éligible à un échange, mais que votre modèle n’est plus disponible. Il vous propose alors plusieurs modèles que vous lui demandez de comparer. Vous faites votre choix, l’assistant commande, et vous n’avez plus qu’à renvoyer votre portable par la Poste. Science-fiction ? C’est pourtant ce que nous a montré OpenAI lors d’une démo à la Conférence GenerationAI. Avec, en bonus, un coup de fil en live pour vérifier les horaires et le stock d’une boutique.

Aujourd’hui, lorsque vous faites ça, vous naviguez entre plusieurs pages : le site du vendeur, ses conditions générales, son catalogue, des sites de comparaison de téléphones… alors que là, vous chattez (ou parlez) simplement avec votre assistant. Cette simplicité apparente masque cependant une transformation profonde de notre rapport au web et soulève de nombreuses questions.

Cette évolution soulève des questions fondamentales : comment le web, encore massivement conçu pour une navigation humaine, s'adaptera-t-il ? Qui rémunérera les créateurs de contenu dans un monde où les agents IA synthétisent l'information, et généreront (beaucoup ?) moins de trafic ? Comment préserver la diversité des sources et éviter la marginalisation des petits acteurs ? Et surtout, comment maintenir notre esprit critique face à des informations pré-digérées ?

Pour explorer ces questions, je commencerai par vous présenter les standards techniques qui émergent pour faciliter la navigation agentique. J'analyserai ensuite les défis que cette révolution pose aux modèles économiques d'internet et aux producteurs de contenu. Enfin, j'esquisserai quelques scénarios possibles pour l'avenir de cet internet des agents, entre opportunités d'innovation et risques de concentration du pouvoir.

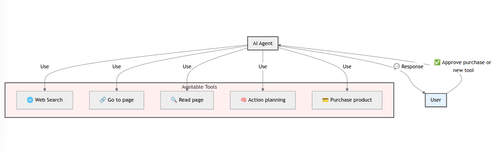

Exemple d’un agent IA et de ses outils

Les standards émergents

Structurer son contenu pour les large language models (LLMs)

Aujourd’hui, Internet est principalement conçu pour une navigation humaine : des pages structurées visuellement avec du html et du css, des publicités, un style adapté à des lecteurs humains… Parser les pages pour une navigation efficace peut donc être laborieux. Adapter son contenu à cette nouvelle source de visiteurs peut alors devenir stratégique afin d'attirer des visiteurs provenant d’une navigation via agents.

L’un des premiers standards émergents pour répondre à cette problématique est le llms.txt. Answer.AI propose de fournir un fichier /llms.txt à la racine des sources, afin de donner des instructions aux agents sur comment lire le site ainsi que du contexte sur le contenu du site. Le fonctionnement de ce fichier est analogue à celui du robots.txt, qui indique aux moteurs de recherche quelles parties d’un site indexer ou ignorer. Ici, le but est d’exposer un contenu adapté aux agents IA en complément du HTML traditionnel destiné aux utilisateurs humains.

Voici la structure du format comme explicité dans le site https://llmstxt.org/ :

# Titre

> [Optionnel] Description du site

[Optionnel] Détails

## Nom de section

- [Nom du lien](https://url.fr/page.md): [Optionnel] à propos du lien

## Optionnel

- [Nom du lien](https://url.fr/page.md)

.

L’initiative est encore récente (03/09/2024), mais plusieurs sites se lancent dans l’adoption de ce standard. Une liste de sites utilisant llms.txt est déjà disponible, et quelques outils commencent à être proposés pour, par exemple, générer son propre llms.txt.

Le Model Context Protocol (MCP), l’USB-C des outils agentiques

La prochaine pièce du puzzle agentique est le MCP : un standard proposé par Anthropic pour harmoniser la manière dont les agents dialoguent avec différents outils. Au lieu de développer pour chaque service des connecteurs spécifiques et souvent coûteux à maintenir, le MCP offre une API universelle. Grâce à ce protocole, un agent peut, en quelques échanges normalisés, interagir avec une multitude d’outils. Cela permet d’en intégrer une quantité potentiellement faramineuse en ayant uniquement besoin de savoir quel endpoint interroger, sans besoin de coder des connecteurs customs à chaque fois.

Plusieurs acteurs technologiques ont déjà déployé leurs serveurs MCP, et ces outils sont déjà consommés par plusieurs clients. Même OpenAI, le concurrent le plus connu des créateurs du MCP, s’y met, promettant de beaux jours à ce standard.

Ensemble, ces standards préparent l'avènement d’agents de plus en plus autonomes et pertinents, capables de remplacer Google en tant que porte d’entrée sur Internet. Avec des conséquences qui pourraient secouer le modèle économique de bien des entreprises du web.

Les enjeux de la rémunération des créateurs de contenu

Le financement par la publicité mis à mal

Ces derniers mois, les agents s’améliorent à vue d'œil et deviennent de plus en plus puissants et pertinents. Si la tendance continue, et si nous nous habituons à leur usage, nous vérifierons probablement de moins en moins leur réponse. Cela veut aussi dire que nous cliquerons de moins en moins sur les liens des sources de l’agent… et sur les pubs du site dont le contenu a servi de source à l’agent.

Quelques chiffres vont dans le sens de l'avènement des agents comme portes d’entrée du web et leur impact sur le trafic des pages qu’ils référencent. Début 2024, Gartner prédisait une diminution de 25% du trafic des moteurs de recherche classiques à horizon 2026. Par ailleurs, Tollbit affirme dans son premier rapport trimestriel que les chatbots IA apportent 96% de trafic en moins aux sites qu’ils référencent. Prenons cependant ce dernier chiffre avec des pincettes, Tollbit étant un peu juge et partie dans cette histoire, vu que leur business model consiste à trouver des solutions de monétisation alternatives à la publicité pour les sites.

On peut donc s’interroger : avoir un business model basé sur la pub sera-t-il toujours tenable pour les producteurs de contenu dans ce scénario ? Cela pose d’autant plus question que les sites les plus pertinents, les mieux optimisés pour les IAs, seront ironiquement les moins visités, vu qu’ils permettront de générer les réponses les plus qualitatives. Tout l’écosystème a donc intérêt à trouver d’autres modes de financement pour les contenus de qualité. C’est ce qu’on voit déjà se concrétiser avec des accords entre gros fournisseurs de contenu et concepteurs d’agents IA.

L'émergence d'une économie à deux vitesses dans la création de contenu

Le Monde, The Financial Times, Reddit, Stack Overflow... OpenAI annonce régulièrement des partenariats avec des groupes de presse ou plateformes de contenu. Les avantages sont clairs. Pour le fournisseur de contenu, une source de revenus sécurisée. Pour l’agent, un accès privilégié à des contenus jugés fiables et de qualité.

Mais derrière cette solution en apparence gagnant-gagnant, se cache une réalité à deux vitesses qui menace la diversité du web. Pour comprendre ce risque, comparons l'écosystème actuel avec celui qui se dessine.

Aujourd'hui, lorsqu’on effectue une recherche sur Google, on a accès à une multitude de sites, petits ou grands. Le blog d'un expert indépendant peut apparaître aux côtés de publications de grands médias, bénéficiant du référencement naturel si son contenu est pertinent (au moins selon les standards de Google). Chaque visite sur ces sites, quelle que soit leur taille, génère du trafic qui peut être monétisé via la publicité ou d'autres moyens.

Demain, avec les agents IA comme intermédiaires principaux, ce mécanisme risque de s'éroder. D'un côté, les grands acteurs qui ont les moyens et l'échelle pour négocier des contrats avec les grands acteurs de l’IA seront rémunérés lorsque leur contenu sera utilisé. De l'autre, cette myriade de sites plus modestes – blogs spécialisés, publications de niche, forums communautaires – verront leur contenu exploité sans compensation, tout en perdant la visibilité directe qui leur permettait jusqu'alors de subsister.

Le risque n'est pas seulement économique. Si cette fracture perdure, c'est la diversité des voix et des perspectives qui pourrait s'appauvrir, laissant place à un paysage informationnel dominé par un nombre restreint d'acteurs majeurs. L'accessibilité à des points de vue variés est ainsi mise en danger sur le long terme.

De nouveaux modèles de financement des producteurs de revenu

Reprendre la main grâce à l’observabilité

Cloudflare propose un outil qui vise à redonner la main aux créateurs de sites web sur ce que font les bots avec leur site. Les promesses de cet outil sont de permettre de bloquer une sélection de bots en un clic, d’observer le trafic issu des bots afin de mieux comprendre ce qu’ils font des données (entraînement ? Utilisation par un agent ?). Les créateurs pourront ainsi toquer à la porte des éditeurs d’agents avec des données factuelles et négocier des contrats pour l’utilisation de leurs données. La prochaine étape annoncée par Cloudfare est de proposer une interface de paiement pour les bots navigant dans le site de ses clients.

D’autres acteurs, comme la start-up TollBit, proposent également aux producteurs de contenu des solutions pour demander un paiement aux bots derrière les agents IA.

L’apparition d’intermédiaires entre les producteurs de contenu et les développeurs d’agents

Certaines start-ups comme la française Linkup, ayant levé 3M€, ou l’étasunienne ProRata AI (25M$), se positionnent sur ce créneau. Elles proposent des solutions pour rétribuer les producteurs de contenu lorsque l’IA utilise leur travail. Ils se positionnent comme un outil de recherche dans des sources fiables (via Gist AI pour ProRata) et rémunèrent leurs sources à l’usage. Ils sont ensuite eux-mêmes rémunérés par les fournisseurs d’agents qui les intègrent.

ProRata AI a d’ailleurs l’ambition d’aller plus loin dans le concept et analyser le texte généré pour ensuite retrouver quel créateur de contenu est à l’origine de quoi. Un vaste chantier sur un sujet chaud au moment où Meta est attaqué en justice pour utilisation de contenu sous droits d’auteur et Google et OpenAI font du lobbying pour inclure l’utilisation de données sous copyright pour l’entraînement de modèles dans le cadre du “fair use”.

Ce mécanisme présente plusieurs avantages : il mutualise les coûts de négociation pour les petits sites, offre une plateforme centralisée pour la gestion des droits et des revenus et promet aux constructeurs d’agents l’accès à du contenu de meilleure qualité qu’avec la recherche classique. Cependant, il ne règle pas complètement le sujet : ces nouvelles plateformes font une curation des contenus qu’elles référencent, les plaçant dans une position de force pour décider d’inclure ou exclure certaines sources.

L’émergence d’un Internet des agents

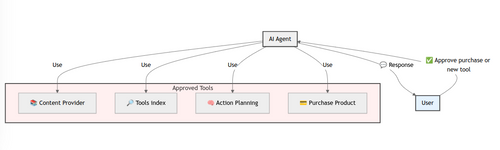

L’agent IA de demain ?

Vers l’émergence des moteurs de recherche pour agents ?

Si un agent est capable d’utiliser n’importe quel outil pourvu qu’il se conforme au MCP, alors on n’aura plus besoin de développeurs pour l’intégrer : l’utilisateur pourrait directement prendre la décision d’autoriser l’utilisation de l’outil par l’agent. Reste à savoir comment et où seront indexés ces outils : auront-nous un Google ou un Amazon des outils ? L’index sera-t-il propre à chaque éditeur d’agents ? En tout cas, on commence à avoir quelques sources pour les trouver, comme Glama.ai ou le repository du Model Context Protocol ou Composio. Cette dernière gère en plus l’authentification des outils, qui n’est pas encore nativement supportée par le MCP, même si c’est dans la roadmap.

N’oublions pas cependant que laisser la liberté à un agent de choisir son outil n’est pas sans risque, surtout lorsque cet outil donne des accès en écriture : corruption ou suppression de données, paiements non souhaités, fuite de données… C’est pourquoi d’ailleurs les applications demandent souvent confirmation avant de faire des actions au nom de l’utilisateur. Aussi, donner accès à un agent à une librairie publique d’outils peut ouvrir la porte à l’utilisation d’outils malveillants, qui disent faire une chose mais profitent des droits qui leur sont accordés pour en faire une autre. Ce sont des problématiques qui rappellent celles des librairies d’applications ou de logiciels mis à disposition par la communauté, donc qui pourraient avoir des solutions analogues : curation par des intermédiaires de confiance, open source…

De l’optimisation des pages pour les moteurs de recherche à celle pour les agents

L’émergence du Generation Engine Optimization (GEO) dans l’univers du web marketing montre que ce tournant commence à être pris. Des agences web comme Noiise, des entreprises comme Hubspot et des universités comme Princeton ou HEC Montréal commencent à s’y intéresser et à écrire sur le sujet.

Quels en sont les premiers enseignements ? L’intégration de mots-clefs s’avère contre-productive pour être mis en avant par un agent, alors que la lisibilité et la qualité de la donnée sont des leviers d’action plus efficaces. Je vous invite à lire les articles référencés plus haut pour plus de détails sur les meilleures pratiques de GEO.

Quelle place pour l’humain dans l’internet des agents ?

Quelle place aurons-nous, humains, dans ce nouvel internet des agents ? Naviguer sur internet sera-t-il toujours une pratique courante ? Aurons-nous toujours accès aux sources du contenu sur lequel se basent les agents pour nous répondre ? Aujourd’hui c’est largement le cas, et c’est en grande partie l’accès à ces sources qui construit notre confiance envers la réponse de ces agents. Mais que se passera-t-il quand leur utilisation sera entrée dans les mœurs ? Et si, pour des raisons de monétisation ou de choix des développeurs d’agents, les sources deviennent peu à peu uniquement accessibles par les agents ?

Selon quels critères seront mis en avant les contenus poussés par les agents ? C’est vrai, aujourd’hui des entreprises comme Google dominent largement le secteur de la recherche sur internet et ont de facto le pouvoir de décider selon leurs propres critères quels sites mettre en avant. Mais la capacité d’un agent à digérer les différents contenus et donner une réponse unique à nos questions amplifie sa capacité à influencer nos choix en tant que consommateurs, mais surtout en tant que citoyens.

Comment garder notre sens critique si on délègue ce travail à un agent ? Voir à ce sujet un papier de recherche de Microsoft et de la Carnegie Mellon University, qui montre que faire confiance à l’IA réduit notre sens critique.

Conclusion

L'essor des agents IA transforme indéniablement notre manière d’interagir avec le web, en amorçant une refonte profonde de son écosystème. Toutefois, si ces technologies enlèvent de plus en plus de friction dans la navigation sur internet, leur adoption entraîne de grands défis.

D’une part, des défis techniques : les standards émergents comme llms.txt et le MCP ne sont encore qu’à leurs débuts, et les usages sont encore émergents. D’autre part, les enjeux économiques liés à la monétisation du contenu posent la question d’un internet à deux vitesses, où seuls les grands groupes seraient en mesure de négocier leur place dans cet écosystème.

Cette transformation ne doit pas se faire au détriment de la diversité et de l’accessibilité de l’information. Pour éviter une concentration excessive du pouvoir entre les mains de quelques acteurs, plusieurs pistes sont à envisager :

- Encourager des standards ouverts et interopérables, afin que les petits créateurs et entreprises puissent s’intégrer aux nouveaux paradigmes sans dépendre de monopoles.

- Explorer de nouveaux modèles de financement, via des standards permettant des micro-paiements pour le contenu ou des modèles de licences équitables pour l’usage des données par les agents IA.

- Maintenir une transparence sur les sources et la fiabilité des contenus proposés par les agents, afin de préserver notre esprit critique face à une information pré-digérée.

- Améliorer la transparence des agents IA. C’est un sujet de recherche actif, et tout n’est pas résolu, mais l’utilisation de modèles open source (ou presque), qui donnent plus d’éléments sur ce qui se passe sous le capot (comme exposer la chaîne de pensées de DeepSeek R1, chose qui n’est pas faisable par les modèles o d’OpenAI par exemple) est un bon début. Exposer également les raisons de choix des différents outils ou des sources utilisées pour répondre va également dans le bon sens.

C’est dès aujourd’hui que nous, développeurs, régulateurs et créateurs de contenu, devons prendre en main ce virage, et nous assurer que cette révolution technologique bénéficie à tous et ne se fasse pas au prix de la diversité et de l’équité numérique.

Merci à Antoine Mazure, Borémi Toch, Gabrielle Le Bihan, Godefroy Clair, María-Dolores Manzanedo, Mathieu Le Morvan et Nicolas Laurent pour leurs commentaires sur l’article.