Gen IA : Comment délivrer aujourd'hui tout en construisant pour demain ?

Maximiser la Valeur de l'IA Générative en Entreprise : Enjeux, Stratégies et Adoption

Introduction

Antoine Moreau, Head of Data & AI for Retail & Luxe chez OCTO Technology, accompagne depuis plusieurs années des entreprises du CAC 40 dans l’exploitation et la valorisation des données grâce à l’IA Générative. Dans ce comptoir diffusé le 13 février 2025, Antoine vise à nous donner les clés pour maximiser la valeur de l’IA Générative, en mêlant les enjeux court et long terme.

L’IA Générative représente un levier de compétitivité majeur, adopté rapidement par le grand public et les entreprises. Elle permet non seulement d’optimiser les opérations actuelles, mais aussi de poser les bases pour de nouveaux cas d’usage à venir.

Créer de la Valeur avec l’IA : Deux Axes Stratégiques

Antoine nous fait part de sa conviction quant aux deux axes qu’il a identifiés pour la création de valeur grâce à la Gen IA :

- Aujourd’hui : Maximiser le ROI, accélérer le time-to-market et mettre en production des solutions performantes. L'industrialisation rapide des modèles est cruciale pour répondre aux besoins métier tout en assurant une performance optimale.

- Demain : Construire une stratégie à long terme pour anticiper et exploiter de futurs cas d’usage. Il est essentiel de développer des bases solides qui permettront une évolution et une adoption continues, en assurant la flexibilité nécessaire pour intégrer les innovations futures.

L’uniformisation des pratiques devient ainsi un enjeu clé pour réduire les coûts, assurer la conformité réglementaire et technique, et favoriser la scalabilité et la résilience des systèmes. Une adoption efficace ne repose pas uniquement sur la mise en production rapide, mais également sur une vision cohérente entre le court et le long terme.

Pour garantir cette adoption pérenne, deux éléments fondamentaux sont à prendre en compte :

- Comprendre les enjeux, identifier les freins et proposer des solutions adaptées : L’IA Générative doit être appréhendée non seulement d’un point de vue technologique, mais aussi stratégique et organisationnel. Identifier les obstacles potentiels, tels que la gestion des données, les limitations techniques ou la réticence des équipes, permet d’adopter une approche plus structurée et efficace.

- Lier le court terme et le long terme : L’objectif n’est pas seulement d’implémenter des solutions performantes immédiatement, mais de s’assurer que chaque décision prise aujourd’hui contribue à la stratégie globale de demain. Il s’agit d’éviter les initiatives isolées qui ne s’intègrent pas dans une vision globale et de garantir une continuité dans les efforts d’innovation.

Ces principes permettent d’adapter les stratégies en fonction du niveau de maturité des entreprises face à l’IA, en favorisant une adoption pragmatique et évolutive.

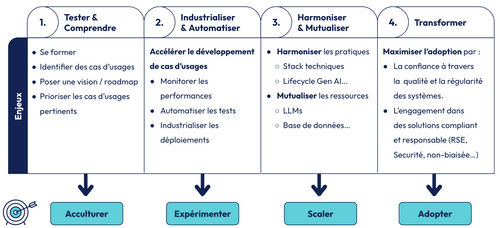

Les Différents Niveaux de Maturité

- Acculturation : Se former, identifier les cas d’usage et établir une roadmap.

- Industrialisation : Automatisation & monitoring.

- Passage à l’échelle : Mutualiser les ressources et optimiser les déploiements.

- Adoption : Intégrer l’IA au cœur des métiers en créant de la confiance utilisateur.

L’adoption commence dès les premières étapes et s’accompagne de stratégies adaptées, vous trouverez ci-dessous la slide plus détaillée correspondante :

Rentrons dans le détail de ces différents niveaux de maturité.

1. Tester et Comprendre

- Formation : Comprendre le cycle de vie d’une solution d’IA est un élément essentiel pour éviter les erreurs classiques de mise en production. Cela inclut la conception, l’entraînement des modèles, l’optimisation, le déploiement, ainsi que la surveillance et la maintenance continue. Identifier les limites inhérentes aux modèles est aussi crucial pour adapter l’implémentation en fonction des contraintes métier.

- Pratique : La mise en place d’un premier POC est une étape clé, mais il est important de ne pas se laisser emporter par l'effet “wahou” d'une démonstration impressionnante sur un jeu de données limité. Un POC doit être évalué dans des conditions proches de la production afin de garantir sa pertinence et sa robustesse sur des volumes de données plus conséquents et variés.

- Vision et Roadmap : Une cartographie détaillée des cas d’usage potentiels est indispensable pour structurer et prioriser les initiatives IA. Il est essentiel d’évaluer chaque cas d’usage en fonction de sa valeur ajoutée et de sa faisabilité technique, afin de définir une roadmap réaliste qui guide les développements futurs et maximise l’impact de l’IA Générative.

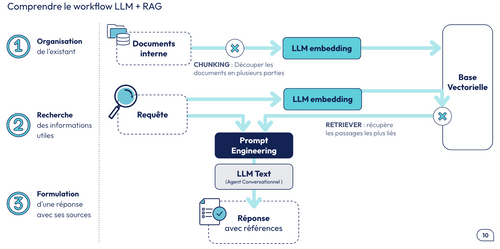

Rappel sur le Workflow des LLMs et des RAGs

- Organisation des documents : chunking et embedding dans une base vectorielle.

- Requête et retrieval : Recherche de similarité et sélection des documents pertinents.

- Génération de réponse : Compilation des informations avec leurs sources.

2. Industrialisation et Automatisation

A. S’équiper pour collaborer et assurer un suivi rigoureux

L’industrialisation d’un système IA implique nécessairement une collaboration efficace entre plusieurs acteurs : data scientists, ingénieurs, et équipes métiers. Pour garantir un travail fluide et structuré, il est essentiel de s’équiper des bons outils :

- Collaboration et versioning : Plusieurs personnes travaillent simultanément sur l’amélioration des modèles et des pipelines de données. Il est donc crucial de mettre en place un système de versioning clair permettant de suivre l’évolution des expérimentations, d’assurer la reproductibilité et d’éviter les conflits entre différentes itérations.

- Personnalisation des métriques : Les indicateurs standards (précision, rappel, F1-score, latence, coût…) ne suffisent pas toujours à refléter les besoins métier. Il est donc nécessaire de définir des métriques adaptées à chaque cas d’usage pour évaluer la pertinence réelle des modèles et leur impact sur les utilisateurs finaux.

B. Monitoring en production : anticiper et optimiser

Une fois les modèles déployés, le monitoring devient un enjeu central avec des contraintes spécifiques :

- Détection des dégradations et alerting : Un modèle peut voir ses performances se détériorer en raison d’un changement dans la distribution des données ou de nouvelles tendances dans les requêtes utilisateurs. Un bon monitoring doit permettre de détecter ces dérives et d’alerter en temps réel pour ajuster ou remplacer le modèle en production si nécessaire.

- Optimisation du coût de monitoring : Sur des plateformes massivement utilisées (comme ChatGPT qui gère des millions d’utilisateurs), il est impossible de monitorer toutes les requêtes en continu sans exploser les coûts. Il faut donc arbitrer entre un monitoring partiel, échantillonné, ou ciblé sur des cas critiques.

- Synchrone vs Asynchrone : Faut-il analyser chaque réponse avant de la retourner à l’utilisateur (monitoring synchrone) ou plutôt effectuer un contrôle en arrière-plan (asynchrone) ? Cette décision dépend du niveau de latence acceptable et du type de surveillance requis.

C. Une vision globale pour un suivi complet

L’outillage et le monitoring sont complémentaires et permettent d’avoir une vue d’ensemble sur les performances des modèles, en intégrant à la fois :

- Des métriques techniques (latence, coût, utilisation des ressources)

- Des métriques fonctionnelles (qualité des réponses, satisfaction utilisateur, pertinence métier)

L’objectif est d’assurer un déploiement fiable, efficace et évolutif, tout en optimisant les ressources et en garantissant une bonne expérience utilisateur.

Antoine insiste notamment sur la construction d’une ground truth qui est une étape essentielle mais chronophage, nécessitant une implication humaine significative. Il s’agit de définir des réponses types pour un ensemble de questions représentatives, garantissant ainsi une base fiable pour évaluer les performances du modèle. Cette tâche implique non seulement un coût humain élevé, mais aussi une attention particulière à la diversité et à la représentativité des données afin d’éviter les biais et d’assurer une évaluation pertinente.

Pour réduire cet effort, il est possible de compléter ces données avec des sources synthétiques. En générant artificiellement des exemples réalistes, on peut limiter la charge de travail des annotateurs tout en conservant une bonne couverture des cas d’usage. Cette approche permet d’accélérer la création de benchmarks tout en maîtrisant les coûts.

Une fois la ground truth établie, l’étape suivante consiste à automatiser l’évaluation des prédictions. Le modèle est testé sur l’ensemble des questions définies, et ses réponses sont comparées aux réponses types pour mesurer l’écart et identifier les points d’amélioration. L’utilisation de métriques adaptées, ainsi que des outils d’automatisation comme LLM as a Judge, permet d’accélérer ce processus et d’assurer un suivi continu des performances.

Pour approfondir ces aspects et découvrir des méthodes d’automatisation spécifiques à l’évaluation des projets RAG, Antoine nous invite à aller lire cet article de Nicolas Cavallo.

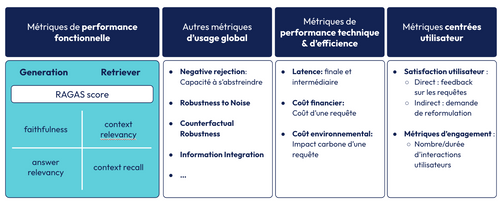

Ces métriques permettent notamment d’identifier les points d’amélioration majeurs de notre solution :

3. Passage à l’Échelle

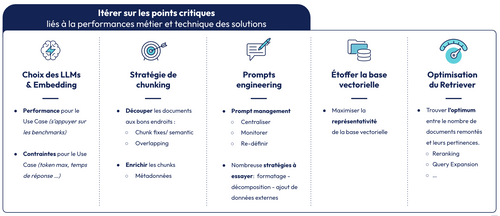

Le passage à l’échelle d’un système basé sur l’IA soulève trois problématiques majeures. Tout d’abord, le coût financier peut rapidement devenir un frein, surtout lorsque le nombre d’utilisateurs augmente. Chaque requête sollicitant un LLM, un modèle d'embedding ou un système d’évaluation (comme LLM as a Judge) engendre des coûts importants qui doivent être maîtrisés. Ensuite, la gestion des quotas impose une vigilance constante : si les limites d’utilisation des modèles sont atteintes, la solution peut devenir inutilisable. Il est donc essentiel d’anticiper ces contraintes d’autant plus que tous les Cloud Providers ne fournissent pas forcément de SLAs. Enfin, la performance et le temps de réponse doivent rester optimaux malgré l’augmentation du volume de requêtes, afin d’offrir une expérience fluide aux utilisateurs.

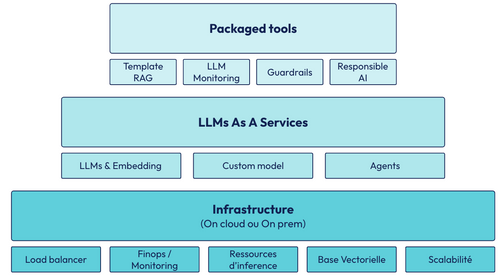

Pour relever ces défis, il est nécessaire d’harmoniser et de mutualiser l’utilisation des ressources. La première brique repose sur une infrastructure robuste combinant par exemple du load balancing, du FinOps et une gestion efficace des ressources. Cela inclut l’hébergement des modèles sur des machines virtuelles adaptées, l’optimisation des coûts et une répartition intelligente de la charge pour éviter les goulets d’étranglement.

La seconde brique consiste à adopter une approche LLM as a Service, c’est-à-dire une bibliothèque de modèles accessibles selon les besoins. Cela peut inclure des modèles pré-entraînés, des versions fine-tunées pour des cas d’usage spécifiques ou encore des agents spécialisés capables d’exécuter certaines tâches de manière plus efficace.

Enfin, la troisième brique repose sur des outils IA packagés facilitant l’industrialisation et l’intégration des modèles. Cela comprend des templates pour implémenter des systèmes RAG, des garde-fous pour encadrer l’utilisation des LLMs, ainsi que des outils dédiés à une IA responsable et conforme aux réglementations.

En combinant ces trois piliers, il est possible de déployer des systèmes d’IA performants, évolutifs et économiquement viables, tout en garantissant une qualité de service constante.

4. Adoption et Transformation

L’adoption d’une solution IA ne repose pas uniquement sur ses performances techniques, mais aussi sur sa capacité à inspirer confiance et à s’intégrer efficacement aux usages des utilisateurs. Pour cela, plusieurs aspects doivent être pris en compte dès la conception.

- Performance et Fiabilité : Une solution ne sera adoptée massivement que si elle est perçue comme fiable et constante dans le temps. Il ne suffit pas qu’un modèle fonctionne bien ponctuellement, il doit être capable de délivrer des performances régulières et prévisibles afin d’instaurer la confiance des utilisateurs.

- Explicabilité : Comprendre comment une IA génère ses réponses est essentiel, en particulier pour des modèles génératifs. Il est important de rendre explicite le cheminement de pensée du modèle, en fournissant des explications ou des références sur les sources d’information utilisées. Cela permet aux utilisateurs de mieux interpréter les résultats et d’éviter une adoption aveugle.

- Engagements RSE : L’IA doit s’inscrire dans une démarche responsable, en alignant ses usages avec les valeurs de l’entreprise sur le plan social et environnemental. Cela passe par une consommation énergétique maîtrisée, une utilisation éthique des données et une transparence sur les impacts de la solution.

- Compliance et Sécurité : La gestion des données est un enjeu clé. Il faut garantir la confidentialité des informations échangées, assurer la conformité avec les régulations (RGPD, copyright, etc.) et mettre en place des garde-fous pour éviter les fuites de données ou les usages malveillants.

L’adoption ne se joue pas uniquement au moment du déploiement, elle commence dès les premières phases de conception. Plus une solution est pensée pour être accessible, transparente et sécurisée dès le départ, plus elle a de chances d’être acceptée et intégrée durablement.

Stratégie Globale et Exécution Opérationnelle

Il existe une tension naturelle entre la vision stratégique à long terme et les impératifs opérationnels du quotidien. D’un côté, les directives globales peuvent être perçues comme des contraintes limitant l’agilité des équipes. De l’autre, les choix faits sur le terrain influencent directement la stratégie, parfois de manière positive, mais aussi avec des conséquences imprévues et potentiellement risquées.

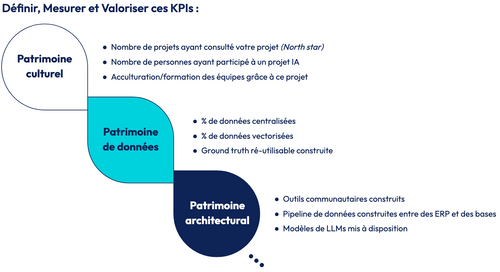

Pour aligner ces deux dynamiques, il est essentiel de structurer un patrimoine IA durable. Cela passe par la définition, le suivi et la valorisation de KPIs d’impact à long terme, garantissant que les décisions opérationnelles restent cohérentes avec les objectifs stratégiques tout en conservant une flexibilité nécessaire à l’innovation.

Voici différents KPI proposés par Antoine, dans différents domaines :

Conclusion

L’IA Générative redéfinit les entreprises, mais son adoption nécessite une approche méthodique, de l’acculturation à l’industrialisation et à l’optimisation.

Les initiatives d’OCTO accompagnent cette transition en structurant les bonnes pratiques et en favorisant les échanges autour de ces enjeux.

Si vous souhaitez en apprendre davantage sur ce domaine, et plus généralement sur la Data et l’IA, n’hésitez pas à vous inscrire aux prochains événements d’OCTO !