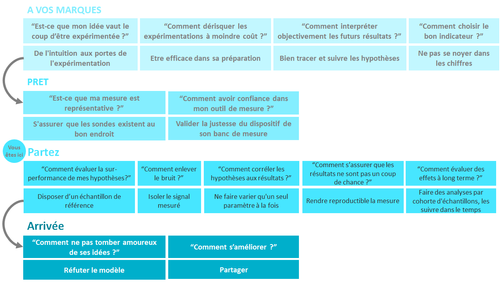

Comment s’inspirer des méthodes scientifiques dans l’innovation produit ! [Part II/III]

Suite à notre première partie, après avoir préparé l'expérimentation de façon scientifique, la dérouler de façon aussi rigoureuse qu'un chercheur est un chemin semé d'embûches.

Comment évaluer la performance du test ? Comment enlever le bruit ? S'assurer que le résultat n'est pas lié qu'au hasard ? Evaluer les effets à long terme ?

Précédemment : la première partie.

Rappel de la situation, où en sommes nous ?

Partez ! Lancez vous !

“Comment évaluer la sur-performance de mes hypothèses?”

Disposer d’une valeur de référence à laquelle se comparer

Afin de mesurer une progression/évolution par rapport à une référence on doit disposer d’un échantillon de référence que l’on prend comme base comparative. C’est en particulier très utilisé dans le domaine médical où par exemple les effets d’un régime alimentaire sont testés sur plusieurs populations. L’une d’entre elles ne subit aucune modification de son régime alimentaire. Celle-ci servira de référence comparative aux autres populations soumises aux régimes alimentaires.

Application à l’innovation produit

Je veux tester une proposition de valeur pour mon service de CV par des campagnes LinkedIn. Pour évaluer une campagne en ligne, le critère est le CTR (click-through-rate : taux de clics). Mais quel est le seuil qui me satisfera : 1%, 0,1% ou 0,01% ? Des références existent sur internet sur les taux moyens de CTR par media. Sur LinkedIn, le taux moyen de 0,025% peut servir de première référence. Cependant, le CTR varie énormément selon le segment de marché et la thématique.

La référence plus sûre est de se baser sur un historique.

Mon entreprise a l’habitude de campagnes LinkedIn sur son service actuel de conseil en recrutement, avec un CTR de 0,015%. Je mets un objectif à 0,02% pour considérer ma campagne comme un succès.

A retenir pour innover comme un scientifique

- Pour toute expérimentation, définir une mesure quantifiée de référence, à partir de son historique, ou à défaut des données du marché,

- Définir un seuil de surperformance par rapport à cette mesure pour valider l’expérimentation et s’autoriser à poursuivre. En dessous, il faudra envisager d’arrêter ou de changer ses hypothèses.

“Comment enlever le bruit ?”

Isoler le signal mesuré

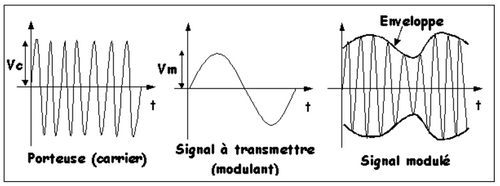

Lorsque l’on mesure un signal il n’est pas rare de mesurer en même temps des signaux parasites qui l’entourent. Il faut alors trouver une astuce pour l’isoler du reste des signaux parasites.

Par exemple, pour isoler un signal infrarouge des éléments extérieurs qui émettent aussi des infrarouges on peut moduler le signal à mesurer par une fréquence très éloignée de l’infrarouge et non bruitée. Le signal recherché est alors porté par une fréquence qu’il est facile d’isoler et complètement débarrassé du parasitage extérieur.

Application à l’innovation produit

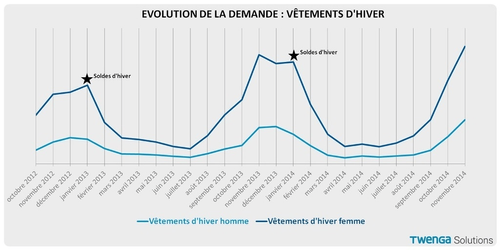

Le business du recrutement est très saisonnier, d’autant plus pour les jeunes diplômés. Les résultats de mon test d’annonces LinkedIn risquent d’être “pollués” par la saisonnalité.

Mon entreprise dispose d’un historique sur le trafic et les taux de clics par mois. Je connais les variations saisonnières. Je peux évaluer l’efficacité de la campagne par rapport au mois équivalent de l’année précédente, plutôt que le mois précédent pour enlever le bruit de la saisonnalité.

A retenir pour innover comme un scientifique

- Veiller aux événements perturbateurs sur le marché qui polluent les données mesurées,

- Penser à désaisonnaliser éventuellement les résultats.

“Comment corréler facilement les hypothèses aux résultats ?”

Ne faire varier qu'un seul paramètre à la fois

Pour évaluer les effets d'un paramètre dans une expérience scientifique on pratique ce que l’on appelle une campagne de tests de mesure.

Pour pouvoir isoler l’effet d’un paramètre clé de l’expérimentation on ne doit en faire varier qu’un seul à la fois.

C’est le seul moyen d’établir une corrélation éventuelle entre une mesure expérimentale et la variabilité d’un paramètre. Cela paraît évident mais sinon comment dire quel paramètre est à l'origine d'un comportement observé si tout bouge !

Application à l’innovation produit

Deux propositions de valeur ressortent des entretiens qualitatifs : “Votre CV en 20 minutes” (axe gain de temps) et “ Un CV dont vous êtes fier !!” (axe crédibilité).

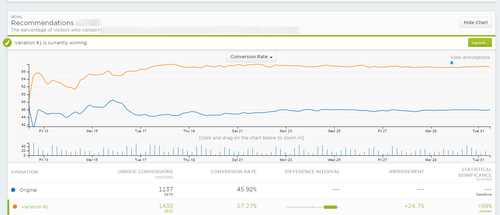

Je veux laisser les chiffres décider, avec une campagne d'A/B testing. Avec un outil spécialisé (comme unbounce.com ou optimezely.com), je teste en concurrence deux versions de landing pages avec les 2 baselines.

Je veille à ce que les 2 soient identiques par ailleurs pour ne pas polluer le résultat.

Sinon, est-ce que A surperforme B parce que les prospects sont plus sensibles au gain de temps, ou parce qu’ils ont plus facilement trouvé le bouton d’inscription ?

A retenir pour innover comme un scientifique

- Ne testez qu’une variation à la fois pour pouvoir interpréter le résultat

“Comment s’assurer que les résultats ne sont pas un coup de chance ?”

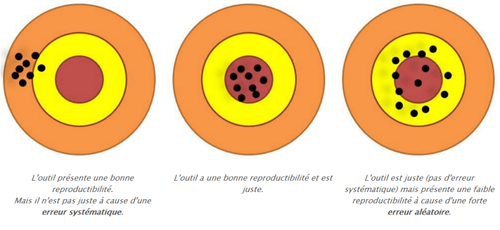

Rendre reproductible la mesure

Une théorie et ses expérimentations associées sont considérées comme justes tant que l’on ne peut prouver son contraire.

Pour que leurs travaux puissent être validés par la communauté scientifique, les chercheurs doivent publier de manière très exhaustive la description de leur expérimentation : banc de mesures, les hypothèses de départs et d’une manière générale l’ensemble de leurs conditions expérimentales, résultats compris.

Ainsi un laboratoire extérieur est en mesure de reproduire cette expérimentation compte tenue du cahier des charges de l'expérience. C’est une condition sine qua non de la validation par la communauté des résultats publiés.

Note: dans le domaine médical c’est actuellement un sujet d’inquiétude puisque la recherche médical vit une crise assez marquée autour de la mauvaise reproductibilité de leurs expérimentations.

Application à l’innovation produit

Après 1 semaine de test A/B, le résultat penche pour la page B : taux de conversion de 18% contre 11% pour la page A.

Une semaine après la tendance s’inverse : 10% contre 13%. Une semaine suivante annoncerait un résultat encore différent. J’ai compris la leçon : avec quelques dizaines de prospects arrivant sur chaque landing page, l’échantillon n’est pas significatif pour ce type d’expérimentation quantitative.

L’outil A/B n’est pertinent que pour des sites ayant un trafic important.

Optimizely fournit un outil pour calculer une taille d’échantillon représentatif : https://www.optimizely.com/resources/sample-size-calculator/?conversion=10&effect=5&significance=90 Analyser les résultats des métriques est un exercice semé de pièges.

Ainsi AirBnB raconte leur déception en voyant que leurs tests A/B sur la nouvelle homepage ne montrait pas d’amélioration significative de la conversion, en contradiction avec les tests qualitatifs qui la plébiscitaient. En affinant les résultats, ils se sont rendus compte d’une amélioration sensible de 2% de la conversion sur Chrome et Firefox, contrebalancée par une chute totale sur IE. En creusant, ils ont découvert un bug sur IE qui polluait les résultats globaux. (cf l’article : experiments at airbnb).

A retenir pour innover comme un scientifique

- Seule une expérimentation sur un échantillon significatif en nombre permet de tirer une potentielle conclusion quantitative,

- Attendez un peu pour reproduire plusieurs fois l’expérimentation,

- Si aucune conclusion ne se dégage, changez votre hypothèse de départ ou votre mesure ;-)

“Comment évaluer des effets à long terme ?”

Faire des analyses par cohorte d'échantillons et suivre les effets dans le temps

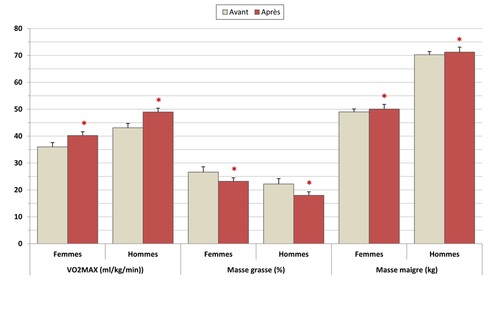

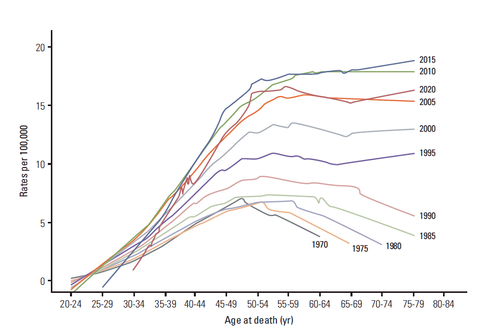

Les études de cohortes sont souvent utilisées en médecine et sciences sociales pour comparer l’évolution de groupes de population sur un temps long.

[caption id="attachment_67905" align="aligncenter" width="669"]

(src: Cancer Research and Treatment : http://e-crt.org)[/caption]

Application à l’innovation produit

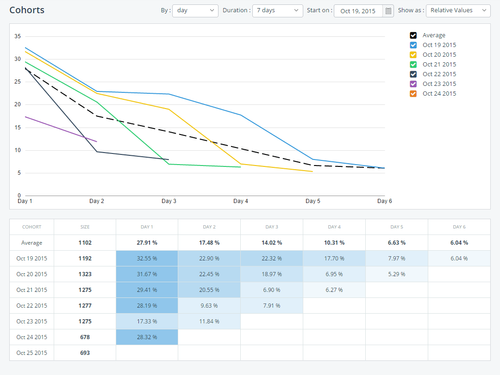

Un an plus tard, le service de qualification de CV est sorti avec une base d’utilisateurs de plus de 500 récents diplômés. Nous cherchons à étendre la base en amont auprès des étudiants pour les CV de stage et d’alternance. Une campagne originale sur facebook le mois de mai est un grand succès, la base augmente de 50% en un mois !

En juin nos KPI d’acquisition restent excellents.

En septembre, je remarque que le taux de rétention à tendance à se dégrader (le nombre d’inscrits qui utilise régulièrement le service).

J'utilise l'analyse par cohorte pour comprendre le phénomène. Je compare les taux de rétention des nouveaux inscrits en mai versus les nouveaux inscrits des mois précédents. Je constate que dans la cohorte de mai, seuls 10% restent sur le service le mois suivant, contre 20% pour les cohortes précédentes. Une hypothèse à valider par des entretiens est que notre service est déceptif pour la nouvelle cible des stages et alternances.

L’analyse par cohorte m'aurait permis de détecter ce phénomène plus tôt.

En effet, il est difficile de détecter sur la masse globale l'effet d'un changement des nouveaux inscrits. L'analyse par cohorte permet d'isoler ce phénomène pour voir l'aiguille bouger plus rapidement.

[caption id="attachment_67906" align="aligncenter" width="725"]

(src:telerik : http://www.telerik.com )[/caption]

A retenir pour innover comme un scientifique

- Suivez des cohortes pour évaluer l’effet de vos changements sur l’usage à long terme,

- Ne vous focalisez pas exclusivement sur l’acquisition,

- Mesurez la rétention et/ou réactivation sur les utilisateurs/clients les plus anciens au fur et à mesure de la mise en place de vos évolutions.

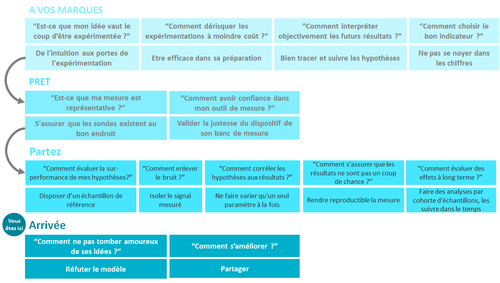

Où en est on dans la vision globale de la démarche ?

La dernière partie, très bientôt !