Avez-vous déjà songé à recruter un Chief Algo Officer ? (Partie 2)

Lors du précédent article, nous avions évoqué le besoin complexe de développer une approche patrimoniale envers son legacy algorithmique et de chercher à améliorer les pratiques existantes.

Cet article revient sur un exemple nous venant du monde de la finance : l'algotrading et développe ensuite les clefs d'une stratégie possible pour développer le contrôle, déclarer et mettre en oeuvre un « ownership » de ses algorithmes.

Algo-trading : décryptage

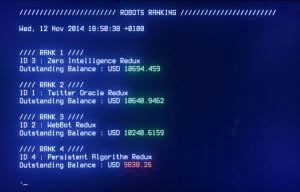

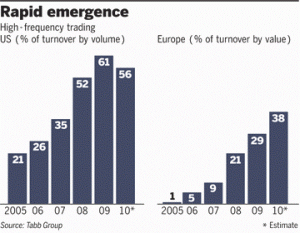

Selon Irene Aldridge dans "Evolution of trading", le secteur financier a réussi à augmenter considérablement sa rentabilité avec l'apparition d'une nouvelle discipline surnommé le trading haute fréquence (une des catégories de trading algorithmique). Depuis sa création, au début des années 1980, le trading haute fréquence a évolué avec l'augmentation des capacités de calcul et des vitesses d'exécution des transactions.

Ce trading est réalisé par un ordinateur qui envoie les ordres en moins de temps qu’il ne faut pour dire ouf. Certaines stratégies utilisées par le trading à haute fréquence posent quelques questions à certains. La première, c’est le Flash trading qui permet de voir avant tout le monde les ordres sur une valeur. Une autre, c’est le Liquidity rebate trading, où le programme analyse tous les ordres entrant sur un marché pour essayer de repérer celui d’un gros institutionnel. Certains hedge funds ont eux développé des programmes pour scanner les ordres sur les dark pools (ces plateformes où les ordres sont exécutés de manière anonyme). Cette liste de stratégie est bien plus longue et c'est même l'objet du livre d'Irène Aldridge.

Selon Timothy Lavin, les algorithmes exécutent maintenant 70 pour cent de toutes les transactions aux US. La vitesse et le volume de négociation quotidien ont propulsé le marché dans une nouvelle dimension : le volume moyen des échanges sur le New York Stock Exchange a augmenté de 181 pour cent entre 2005 et 2009, tandis que le temps nécessaire pour exécuter une opération sur ses systèmes électroniques a chuté à 650 microsecondes.

Il est raisonnable de penser que cette forme de trading algorithmique est apparue progressivement pour devenir de plus en plus structurante dans le système boursier international (en quelques années), en posant de nouveaux problèmes réglementaires et éthiques.

Les flash crash : limites de l'algo-trading ?

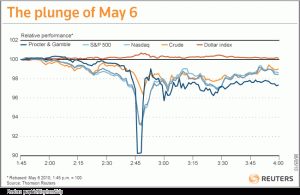

Le Flash Crash de 2010, parfois nommé tout simplement Flash Crash, fait référence au krach arrivé le 6 mai 2010 aux États-Unis : un effondrement boursier qui a duré quelques minutes. Après presque 5 mois d’enquête, la Securities and Exchange Commission (SEC) et la Commodity Futures Trading Commission (CFTC) ont déposé un rapport conjoint le 30 septembre 2010.

Le rapport précise que le le 6 mai a été dès le début d'une journée exceptionnellement turbulente pour les marchés en raison de la crise de la dette en Europe, expliquent les régulateurs. Dans ce contexte face à «une volatilité inhabituellement élevée et une réduction des liquidités», un courtier a lancé un programme de ventes portant sur 75.000 contrats à terme sur l’indice S & P 500. Les contrats sur un indice boursier sont destinés à parier sur son évolution future. Pour cela, ce courtier a choisi un programme informatique complexe qui a effectué la vente en seulement 20 minutes, une durée très réduite pour un volume si important (représentant plus de quatre milliards de dollars). Le rapport explique ainsi en détail comment une grande firme, vendant une quantité inhabituellement importante de contrats a dans un premier temps épuisé les acheteurs disponibles, et comment ensuite les machines à algorithmes effectuant les transactions à haute fréquence (HFT) ont commencé à vendre de manière agressive, accélérant l’effet de vente du fonds et contribuant à la forte baisse de la valeur.

Ce cas illustre bien la complexité qui peut se développer si les utilisateurs n'entretiennent pas une maîtrise des programmes utilisés, des limites et des utilisations à ne pas faire.

Les axes majeurs pour piloter son patrimoine algorithmique

Maîtriser les limites

Savoir ce que votre algorithme ne peut pas vous dire est tout aussi important que de savoir ce qu'il peut. Il est facile de succomber à la croyance erronée que les prévisions faites dans un contexte seront applicables aussi bien dans un autre. Un exemple issu de la compétition Netflix 2009 illustre bien ce cas : l'algorithme qui prévoie avec exactitude ce qu'une personne voudrait commander par la poste en DVD n'a pas été aussi juste pour conseiller quel film une personne voudrait voir tout de suite.

Être explicite sur ses objectifs

La fin ne justifie pas les moyens. Ce proverbe signifie que parvenir à une bonne fin ne justifie pas tous les moyens. Nous savons tous qu'il y a des objectifs et des compromis. Nous pouvons refuser un peu de profit aujourd'hui pour un gain de réputation demain. Nous pouvons lutter pour l'égalité, même si elle provoque des douleurs organisationnelles à court terme. Les algorithmes vont poursuivre un objectif avec détermination. La meilleure façon d'atténuer cet effet est d'être très clair sur tout ce que vous voulez atteindre. Pour ce faire, il faudra lors de l'interprétation des résultats avoir bien en tête ces compromis et les objectifs implicites attendus. Avec un objectif de base et une liste de préoccupations en tête, le créateur de l'algorithme peut alors construire des compromis. Souvent, cela peut signifier élargir l'objectif pour inclure des résultats multiples, pondérés par importance.

Tenir compte de la feedback loop pour ne pas perdre de vue que les algorithmes sont souvent myopes

Les algorithmes ont tendance à être myope. Ils se concentrent sur les données à portée de main pour atteindre des résultats de court terme. Il y a nécessairement une tension entre le succès à court terme et les bénéfices à long terme et des objectifs plus larges d'une entreprise. Les humains comprennent cela implicitement, les algorithmes ne le font pas, sauf si vous leur dites de le faire.

Ce problème peut être résolu lors de la phase de définition des objectifs en identifiant et en précisant les objectifs à long terme. Mais quand agissant sur les prédictions d'un algorithme, les managers et opérationnels doivent également ajuster en permanence la justesse avec laquelle l'algorithme est cohérent avec les objectifs de long terme.

Viser l'excellence

La notion de complexité algorithmique est rarement évoquée dans l'évaluation de la faisabilité de certains projets. L'analyse de la complexité permet de savoir si la réponse à un problème peut être donnée très efficacement, efficacement ou au contraire être inatteignable en pratique (et en théorie), avec des niveaux intermédiaires de difficulté entre les deux extrêmes. Pour atteindre l'excellence, il pourra être efficace dans quelques cas d'apporter des limitations de bon sens dans les valeurs (relatives ou absolues) des variables à considérer, ou dans le cas où des calculs identiques et longs risquent d'être répétés souvent, de mettre en mémoire les résultats intermédiaires pour éviter ces recalculs, mais aussi de veiller à ne pas faire des calculs qui ne servent à rien.

Déclarer son ownership sur son patrimoine algorithmique

De plus en plus de grandes structures fonctionnent sur la base de systèmes « Legacy » qui « font » tourner le métier. Ces derniers ont parfois même structuré la manière de faire le business en raison des limites techniques de l’époque de leur implémentation ou de l’organisation de l'époque. Ces points deviennent encore plus critique lors des changements générationnels qui renforcent encore la perte de connaissance sur ces systèmes.

Dans le Secteur Public, les députés ont adopté, mercredi 20 janvier 2016, un amendement au projet de loi « pour une république numérique », destiné à rendre publiques les règles des principaux algorithmes utilisés par l’administration pour les impôts, les allocations familiales ou encore l’affectation des enfants dans les collèges. « Les administrations (...) rendent publiques en ligne, dans un standard ouvert et aisément réutilisable, les règles définissant les principaux traitements algorithmiques utilisés dans l’accomplissement de leurs missions lorsqu’ils fondent des décisions individuelles », prévoit le texte.

Chez OCTO, nous préconisons qu’une structure de l'organisation se saisisse de ce sujet, développe cette prise de conscience et se mette en mesure à la fois de s’assurer de la pérennité de ce patrimoine mais surtout de le remettre en cause, de le challenger pour offrir de nouvelles possibilités au métier et être le porteur d'une démarche d'excellence algorithmique.

Quand cela est possible, il faudra envisager même de s’inspirer de la démarche d’Open Innovation voire d’Open Data pour partager entre partenaires à petite ou très large échelle le fonctionnement (voire la transparence) de certains de ses algorithmes stratégiques.

Finalement, avez-vous enfin songé à recruter votre Chief Algo Officier ?