Agents IA : tout ce qu'il faut savoir

Considérés comme la nouvelle phase de la révolution de l’IA, les agents IA se déploient dans nos entreprises et s'immiscent dans notre quotidien. Mais que recouvre vraiment cette “agentivité” dont tout le monde parle ? Prenons un moment pour démystifier les concepts, les usages actuels, et les enjeux à venir.

Vous pouvez retrouver le contenu de cette article en vidéo : Comptoir OCTO : Agents IA

Du LLM simple au agents

Depuis l’arrivée de chatGPT (nov 2022), qui nous a fait entrer dans la révolution de l’IA générative, l’utilisation des modèles de langages s’est considérablement développée. Cette utilisation a ouvert la voie à une nouvelle phase de la révolution de l’intelligence artificielle : l’ère des agents IA.

Anthropic, à la suite d’un article fondateur (Building Effective Agents), introduit la notion de système agentiques, dans lequel il est important de distinguer deux notions architecturales importantes : Les workflows et les agents.

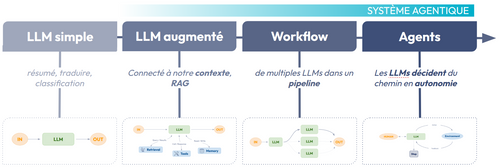

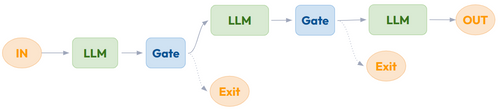

Fig 1 : du LLM aux agents IA

Dans la suite de cet article, nous conserverons ces distinctions qui semblent gagner en popularité au sein de la communauté IA. Nous détaillons les différentes étapes qui nous amènent à introduire de plus en plus d’agentivité dans nos processus (fig 1).

- Le LLM augmenté, la brique essentielle d’un système agentique. On connecte notre LLM à un environnement : des outils, des informations (RAG), etc..

- Agentic WorkFlow : On construit des pipelines de plus en plus complexes qui orchestre l’utilisation de LLMs

- Agents IA : On introduit une autonomie de plus en plus importante dans le processus.

- En pratique: Quand et Comment déployer ces agents IA en entreprise.

I. Le LLM augmenté

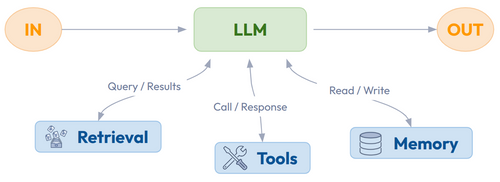

Fig 2 : LLM augmenté

Ces dernières années nous avons commencé à “connecter” les LLMs à du contenu et des outils externes. Nous avons notamment vu l’essor des applications RAG (Retrieval Augmented Generation) consistant à augmenter les LLMs par de la donnée externe. Pour plus de détails : cette vidéo ou cet article : Maîtriser le RAG.

Le lien entre d’un côté le LLM et de l’autre un environnement composé d’outils (API principalement) et bases de données, constitue ce que nous appelons l’augmentation d’un LLM. C’est la brique essentielle dans un système agentique.

MCP où le besoin de standardisation

L’utilisation grandissante d’outils pour augmenter les LLMs a amené à un problème évident : les applications créées deviennent plus complexes et surtout dépendent d’outils externes. En effet, la méthodologie principalement utilisée jusqu’à présent était le “function calling” : on ajoute dans le prompt system une information qui explique comment faire appel aux outils avec les différentes fonctions. Le “prompt system” fait partie intégrante de notre application LLM, si une fonction d’un outil évolue, il faudra également mettre à jour notre “prompt system” et donc notre application… Afin de limiter cette dépendance forte (entre notre application IA et les outils), un standard émerge : MCP ( Model Context Protocol), créé par Anthropic.

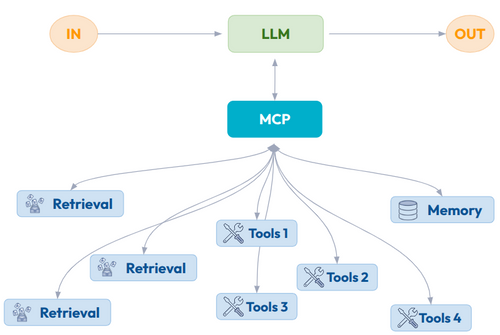

Fig 3 : MCP le protocole pour standardiser le lien entre un LLM et son environnement.

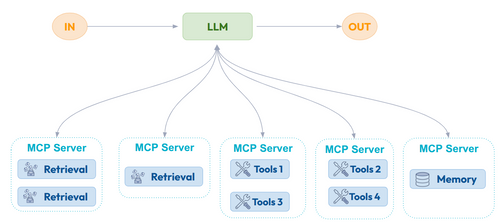

De nombreux articles expliquent très bien le fonctionnement de MCP : exemple d'article sur le blog Octo. La principale force de MCP est de découpler l’exposition d’outils du fonctionnement de notre LLM. Des équipes peuvent en toute autonomie créer un MCP server (fig 4) qui exposera du contenu ou des services en toute autonomie avec son cycle de vie. Cette standardisation ouvre la voie à la naissance d’un écosystème de contenu et de service dont l’objectif principal est d’être lisible pour un LLM.

Fig 4 : Construire des serveurs MCP pour rendre du contenu ou des services visibles par des LLMs

II. Agentic Workflow.

Qu’est qu’un “agentic workflow” ?

Dans un système agentique, nous parlons de workflows lorsque les LLMs et les outils sont orchestrés selon des parcours définis et contrôlés. Une orchestration souvent matérialisée par des nœuds et des liens (fig 5). Par exemple, si nous voulons automatiser l’analyse de nos factures, nous pouvons utiliser un LLM ( voire un modèle de vision) pour récupérer des informations depuis un document pdf. Nous ajoutons ensuite des traitements LLM (validation d’une note, accord d’un remboursement, etc) qui ne se déclencheront qu’en fonction d’informations précises. Nous pouvons également laisser une validation humaine dans le “workflow”, surtout si ce dernier reproduit un processus existant dont les erreurs ont des conséquences importantes.

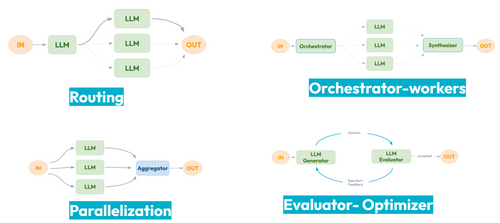

Fig 5 : Prompt Chaining, un exemple d’agentic workflow

Les types d’un “agentic workflow” ?

La construction de “workflow” étant assez libre, quelques types d’orchestration adaptés à l'utilisation de LLMs émergent :

- Prompt chaining : Idéal pour des objectifs qui se décomposent en sous tâches plus simple et maitrisable.

- Routing : L’idée du “routing” est d’utiliser un LLM pour classifier une entrée.

- Orchestrator - workers : Utiliser la capacité des LLM pour définir et donner des tâches à d’autres LLMs (workers).

- Parallelization : Devant des tâches de plus en plus longues, la mise en place de traitements en parallèle devient obligatoire.

- Evaluator - Optimizer : Un LLM “Generator” propose des solutions. Un LLM “Evaluator” évalue la qualité ( accepte ou rejette) et fournit du “feedback” sur les raisons d’un rejet.

FIg 6 : Quelques types d’agentic worflow

III. Agents IA

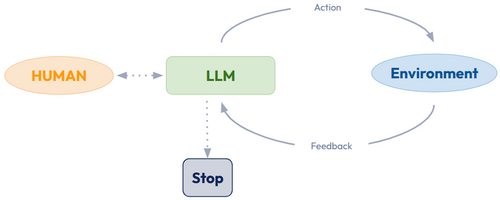

Fig 7: schéma d’un agent IA

Qu’est ce qu’un agent IA ?

Un agent IA est un système autonome, piloté par un modèle d’intelligence artificielle (souvent un LLM), capable de raisonner, planifier et interagir avec son environnement pour atteindre un objectif donné.

Cette définition que nous vous proposons, émerge notamment de l’analyse des définitions proposées par des grands acteurs de l’IA (Tableau 1). Ils font tous apparaître les points les plus importants lorsqu’on parle d’agents IA : Autonomie, modèle (souvent LLM), planification, interaction avec un environnement et l’atteinte d’un objectif donné.

| Google : https://www.kaggle.com/whitepaper-agents | AI agent can be defined as an application that attempts to achieve a goal by observing the world and acting upon it using the tools that it has at its disposal. Agents are autonomous and can act independently of human intervention, especially when provided with proper goals or objectives they are meant to achieve. Agents can also be proactive in their approach to reaching their goals. Even in the absence of explicit instruction sets from a human, an agent can reason about what it should do next to achieve its ultimate goal |

|---|---|

| HuggingFace https://huggingface.co/learn/agents-course/unit1/what-are-agents | An Agent is a system that leverages an AI model to interact with its environment in order to achieve a user-defined objective. It combines reasoning, planning, and the execution of actions (often via external tools) to fulfill tasks. |

| Anthropic : https://www.anthropic.com/engineering/building-effective-agents | Agents are systems where LLMs dynamically direct their own processes and tool usage, maintaining control over how they accomplish tasks. |

| OpenAI https://cdn.openai.com/business-guides-and-resources/a-practical-guide-to-building-agents.pdf | Agents are systems that independently accomplish tasks on your behalf. |

| AWS https://docs.aws.amazon.com/prescriptive-guidance/latest/agentic-ai-foundations/introduction.html | In a world of increasingly intelligent, distributed, and autonomous systems, the concept of an agent—an entity that can perceive its environment, reason about its state, and act with intent—has become foundational. Agents are not merely programs that execute instructions; they are goal-oriented, context-aware entities that make decisions on behalf of users, systems, or organizations. Their emergence reflects a shift in how you build and think about software: a shift from procedural logic and reactive automation to systems that operate with autonomy and purpose. |

| Table 1 : Quelques définitions d’agents |

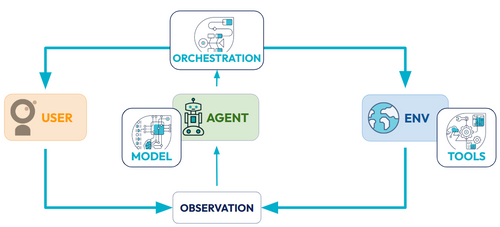

Quels sont les composants d’un agent IA ?

Il existe trois composants principaux d’un agent IA : Le modèle, l’orchestration et les outils (Tools).

- MODEL : Le modèle de langage va être l'élément central dans la prise de décision. Il peut s’agir d’un à plusieurs modèles (de taille, modale(s) ou, capacités différentes). Il peut être utilisé pour suivre des framework classique de raisonnement ou logique telle que : Chain Of Thought ( Chaîne de pensée), ReAct. Il peut s’agir d’un modèle fine-tuné spécifiquement pour notre architecture : capacités améliorées pour appeler des outils internes et comprendre des problématiques métier spécifiques.

- ORCHESTRATION : L’orchestration est la définition de l’architecture cognitive de l’agent, son moyen d’opérer. On va définir la boucle de raisonnement, à travers des aides à la planification ( chain of thought -COT, self-reflexion, etc..) et à l’organisation ( Prompt engineering Framework - ReAct). Certaines fonctionnalités centrales vont également être définies comme la mémoire et la façon de la mettre à jour au cours des interactions. Les interactions avec l’environnement ( LLM to actions) et avec l’humain (Human in the loop) seront également définies dans cette partie.

- TOOLS : La définition des actions réalisables par nos agents, qu'elles soient disponibles via des serveurs MCP, de simples APIs ou du code reste un point important dans la constitution de l’environnement avec lequel l’agent interagit.

Fig 8 : Les composants d’un agent IA

Nous détaillons plus en détail ces composants en vidéo : Le comptoir Octo -Agents IA

IV. En pratique : Les agents IA

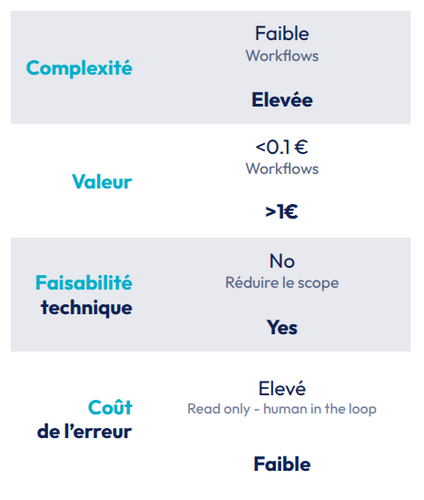

Quand est ce qu’on a besoin d’agents IA ?

Comparativement aux “agentic workflow”, le grand potentiel des agents IA réside dans leur autonomie. Une autonomie encore très compliquée à contrôler : multiplication des hallucinations, difficulté à s’arrêter, coût exorbitant (appels importants et non maîtrisés à des LLM), etc... C’est pourquoi, il faut se poser la question de l'intérêt d’aller sur ce type d’architecture.

- Complexité : Est ce que mon besoin est complexe ? Si ce n’est pas le cas, un workflow peut sans doute suffire.

- Valeur : Est ce que la valeur de ma tâche est importante ? L'utilisation unitaire d’agent IA peut rapidement coûter quelques euros, cette valeur doit donc être suffisamment élevée pour justifier ce coût.

- Faisabilité technique : Est ce que le problème que l’on cherche à résoudre nécessite des capacités et des informations qui sont disponibles par les modèles (LLMs) utilisés.

- Coût de l’erreur : Quel est le coût d’une erreur ? Les agents IA, en plus d’être non déterministes, ont une probabilité non nulle de produire des résultats aberrants. Cette probabilité d’erreur doit être mise au regard de son coût métier. Si un agent a la possibilité d'enclencher des services coûteux (réserver un hôtel, commander un taxi) voire dangereux (ouverture d’une vanne de gaz, etc ), on ajoutera souvent des contraintes de validation humaine (Human in the loop).

Fig 9 : Quand est ce que l’utilisation d’agents IA est envisageable ?

Un des succès les plus récents des agents IA porte sur le développement logiciel (Assistants de code voire Vibe Coding). C’est un contexte où l’utilisation d’agents IA est déjà rentable, ce que confirment les valorisations et revenus de certains acteurs comme Cursor. En effet :

- La Complexité est élevée : Passer d’un document fonctionnel, technique à des lignes de codes n’est pas simple.

- Une Valeur importante : La valeur d’un logiciel de qualité est le cœur de nombreuses entreprises, et c’est souvent pour cela qu’elles sont prêtes à payer assez cher des applications logiciel.

- Des signes de faisabilité technique : Les LLM ont maintenant de très bonnes capacités à coder.

- Les erreurs peuvent être réduites : Le développement logiciel a fait émerger une rigueur de tests automatisés (pyramide de tests) afin de réduire les erreurs logiciel (et donc le coût)

Comment déployer des agents IA en entreprise ?

De nombreuses solutions ont émergé pour faciliter la création d’un “agentic workflow” et d’agents IA. Elles ne s'adressent pas toujours au même public. On peut différencier des outils qui s’adressent principalement à des développeurs/AI engineer (Full code) de ceux qui promettent une démocratisation de l’IA via des outils No-Code s’adressant à un public très large d’utilisateurs (fig 10).

Liste non exhaustive : dust.tt, Microsoft Copilot, Zapier agents, Onyx.app, Flowise, Langflow, Vertex agents, Bedrock agents, n8n, dify, Mindflow, Dataiku, OpenAI agents, Pydantic-AI, Smolagents, Autogen, Google-adk, langgraph, CrewAI

Fig 10 : Liste d’outils pour déployer des agents IA

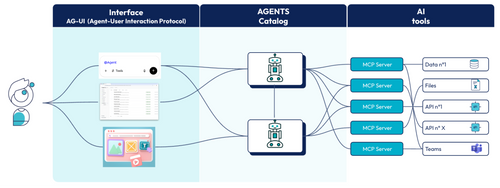

Introduire les agents IA dans mon système d’information

Les agents IA constituent un nouvel acteur dans le système d’information (SI), entraînant par la même occasion de nouveaux types d’intéractions à préparer .

- Une interaction entre ces agents et les services (tools) existant ou à venir de mon SI. L’émergence du protocole MCP est un des principaux leviers de standardisation.

- Une interaction entre les agents eux-mêmes. Des protocoles comme A2A (Agent2Agent) ont émergé mais à date aucune solution ne semble se démarquer. Il est par exemple envisagé d’utiliser le protocol MCP pour exposer un agent, simplifiant ainsi le catalogue IT : ce dernier n’expose que des serveurs MCP dont certains sont des agents.

- Une dernière interaction émerge entre les agents et les utilisateurs (l’humain). De la même façon des protocoles essaient de s’imposer pour standardiser ces échanges : par exemple AG-UI (Agent-User Interaction Protocol)

Fig 11 : Interaction autours des agents IA.

Conclusion

Bien que pour beaucoup, la frontière peut paraître floue entre ce que Anthropic appelle des “agentic workflow” et les “agents IA”, nous conseillons de débuter avec les workflows, ce qui assure une certaine stabilité et maîtrise. En effet, il n’est pas encore possible pour des questions de “coût” et “performance” de rendre rentable de nombreux projets d’agents IA en 2025. Il faut cependant être conscient que les coûts se réduisent rapidement (prix d’un équivalent GPT4 divisé par 1000 en 1.5ans) et la performance unitaire des LLMs s’améliore considérablement (le niveau des tâches réalisées double tous les 7 mois )… Ce qui n’est pas rentable aujourd’hui le sera peut être dans quelques mois ou années.