La Grosse Conf 2024 - Vision AI

Article écrit par Arielle Mimouni et validé par Eric Biernat.

Introduction

Eric Biernat est directeur chez Octo Technology et y dirige l’activité Intelligence Artificielle. Depuis 2011, il est l’un des guides du mouvement Big Data Analytics et accompagne ses clients voulant tirer parti de l’intelligence artificielle. Il est le co-auteur du livre primé Data Science: fondamentaux et étude de cas. Eric Biernat participe à de nombreuses conférences et comités dont l’Académie des technologies.

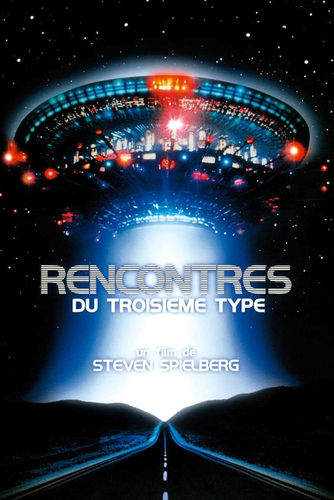

Eric Biernat ouvre la journée de la Grosse Conf. avec sa vision des évolutions à venir et nécessaires de l’Intelligence Artificielle. Il démarre son exposé avec une scène du film “Rencontres du troisième type” de Steven Spielberg où on entend les 5 fameuses notes écrites par John Williams. La musique est, dans le film, interprétable comme une passerelle entre des civilisations qui n’ont aucune base commune de communication. La référence au film jalonne le talk qui, sur un ton futuriste, développe les points communs et de divergence entre la rencontre de l’artificiel et du naturel. L’intelligence artificielle est une nouvelle espèce dont l’arrivée sur terre suscite bien des débats techniques, scientifiques, éthiques, philosophiques et même spirituels. Ces débats sont parfois très polarisés, et se cristallisent souvent autour de la consommation énergétique. Eric Biernat va plus loin : il existe entre le naturel et l’artificiel deux points de rencontre. Nous devons maintenant nous atteler au développement du troisième point de rencontre pour réellement déverrouiller la puissance de cette technologie! A nous d’y travailler!

Les points de rencontre entre le naturel et l’artificiel

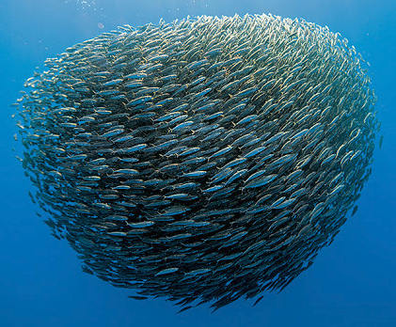

- Premier point de rencontre : l’inspiration. La nature au sens large a inspiré énormément d’avancées technologiques. Parmi les exemples cités, la dopamine qui inspire les algorithmes de renforcement ou encore les comportements sociaux de certaines espèces comme les bancs de poissons qui ont inspiré l'optimisation de trajets.

- Deuxième point de rencontre : le résultat. “L’IA est au rendez-vous de ce qui paraissait être la chasse gardée de l’humain”. Qu’il s’agisse de MidJourney qui produit des images bluffantes, du générateur de vidéos de Sora, de la musique produite par IA ou enfin de toute la galaxie des LLMs, les humains sont impressionnés par le produit de l’IA. Pour illustrer, Eric Biernat invite le public à le rejoindre sur un karaoké de “la chanson de la Grosse Conf” créé par une IA! Trois airs tout à fait convaincants sont proposés : reggae, rock des années 80 et rythmes de Django Reinhardt. L’IA met l’ambiance en conférence!

Eric Biernat termine avec deux images fortes : Kasparov qui est battu aux jeux d’échecs par un super ordinateur IBM (Deep Blue) en 1996 et Lee Sedol battu au jeu de go par AlphaGo de GoogleDeepmind en 2016, avec ce même sentiment d’émotions partagés : on est ébahi et résigné. Excité et stressé face aux avancées fulgurantes de l’IA.

Il n’existe aucun point en commun entre les moyens mis en oeuvre par l’IA et la Nature

Malgré l’engouement et parfois la peur que peut susciter cette nouvelle technologie, il s’agit de se poser les bonnes questions. “Le résultat est là, mais à quel coût ?”. Eric Biernat l’affirme : il n’y a pas de point de rencontre sur les moyens mis en œuvre :

- La nature est causale alors que l’IA est massivement corrélative.

- La nature est efficiente alors que l’IA est énergivore.

- La nature s’adapte alors que l’IA est statique. On la rend dynamique, mais en ajoutant des couches superficielles.

- La nature est explicable, mais les LLMs se transforment de plus en plus en boîtes noires.

La backpropagation est aussi évoquée, symbole du gouffre abyssal entre l’apprentissage naturel et artificiel. la backpropagation - méthode d'entraînement des réseaux de neurones - qui motive de nombreux sujets de recherche.

Récemment, Yoshua Bengio et Geoffrey Hinton ont développé une thèse critique sur la backpropagation et montré en quoi elle participe à creuser l’écart entre le naturel et l’intelligence artificielle. Parmi les problèmes remontés, on citera “the target problem”. Le mécanisme d’apprentissage chez l’humain est encore peu connu, mais il n’est pas fondé sur un entraînement supervisé comme pour l’intelligence artificielle. On n’apprend pas à reconnaître un chat en observant 50 photos de chats sous toutes ses formes. On peut également rappeler qu’alors que la backpropagation implique une connexion symétrique entre les neurones pour passer le signal dans des directions réversibles, les connexions entre les neurones du cerveau ne fonctionnent pas ainsi. Pour plus d’informations à ce sujet, la lecture de ce papier de recherche “Backpropagation and the brain” de T. Lillicrap, A. Santoro, L. Marris, C. Akerlman et G. Hinton ainsi que cette vidéo de Yannick Kilcher qui l’explique, sont instructives.

Eric Biernat conclut : ”Plus on cherche à avoir des résultats proches de la nature, plus on creuse l’écart”. Pour tenter d’expliquer cette situation, il évoque quelques “coupables” : Turing et son jeu de l’imitation qui se focalise uniquement sur le résultat, sur l’interaction et jamais sur les moyens mis en oeuvre, ou encore la recherche en IA, où l’écrasante majorité des publications fait la part belle à la performance , sans jamais prendre en compte des contraintes de moyen.

Enfin, Eric Biernat évoque l’obsession de l’ingénieur à rendre la nature “programmable” : “Dans tous les processus informatiques (un mail, une communication zoom, le fait de jouer en réseau, etc.), si on va suffisamment profond, il y a bien un déplacement d’électrons, d’ondes électromagnétiques, des équilibres qui se font dans un circuit électronique. Ces déplacements, ces équilibres se font de façon optimale mais cette couche fondamentale n’est pas facile à canaliser, à utiliser, à programmer pour ne pas dire exploiter.”

L'informatique est finalement une couche au-dessus de ces phénomènes physiques. L’informatique - à l’opposé de la physique - est relativement facile à manipuler et, ajoute le côté déterministe bien commode pour un système d’informations. Il est évidemment plus aisé de réaliser un code python que de faire l’usinage et la programmation de circuits électroniques en minimisant les incertitudes du monde analogique. Mais cette couche de programmation bien commode nous a une nouvelle fois éloignés de la nature et de son efficacité.

Vers une IA plus proche de la physique ?

La question est alors l’architecture de l’IA : “Est-ce qu’on a forcément besoin de repartir de cette couche informatique pour bâtir l’IA au-dessus de ça ? Est-ce que, quand on fait de l’IA, on ne manipule pas déjà des incertitudes ?” Les pistes de réflexion proposées par Eric Biernat sont les suivantes :

- Se rapprocher des “Energy Based Model” (EBM)? Ces modèles sont conçus pour que lorsque la data qu’ils reçoivent est en cohérence avec leur compréhension, alors l’énergie est minimum. A l’inverse, l’énergie est maximum si la data reçue n’est pas en cohérence. En inférence, on souhaite prédire la cohérence de Y (input) en fonction de X (input également) pour Y = f(X). Si l’on applique le principe des EBM, l’objectif est alors d’obtenir la cohérence du couple (X;Y). Cela est une approche puissante pour modéliser des ensembles complexes sans supervision et sans labellisation. Sur cette vidéo, Yann Lecun explique ce concept.

- Une équipe du MIT a travaillé sur le principe de “Liquid Neural Network” et a montré qu’en cherchant à rendre leur approche plus naturelle, ils ont résolu la causalité. Leur exemple se fait sur de la conduite autonome. Ils réussissent à montrer que le modèle regarde au loin (comme nous humains) et non sur les bords.

- Karl Friston, très écouté spécialiste de l’intelligence naturelle, explique que le cerveau humain cherche à éviter la surprise, définie comme la divergence entre la prédiction du cerveau et la réalité des choses. Il cherche à minimiser la surprise ET la complexité. Il cherche donc à avoir une représentation performante, mais aussi économique, ce qui est nouveau. Si on suit cette idée pour l’IA, on pourrait construire des modèles qui, en incluant dans la fonction coût des paramètres tels que les flops et la complexité de la solution, minimiseraient les contraintes, et donc les moyens mis en œuvre dès la conception.

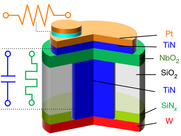

- Des nouveaux hardwares font leur apparition. Le “memristor” est une résistance non fixe, qui peut changer sa valeur et qui a une fonctionnalité de mémoire. En réseau, ces résistances peuvent faire des multiplications de matrice en temps constant. En utilisant ce type de hardware pour du deeplearning, on est au plus proche de la physique et de plus en plus capable d’exploiter les équilibres naturels qui se font sur un circuit électronique. On s’approche ici d’une efficience énergétique jusque-là non vue et cependant indispensable pour résoudre le problème de la consommation énergétique liée à l’inférence.

L’analogique pourrait être le nouveau graal de l’IA efficiente en visant un lien direct entre la physique et les données d’entrées - par exemple des données d’entreprise.

- Eric Biernat termine en citant Geoffrey Hinton : “If you want your trillion parameter neural net to only consume a few watts, mortal computation may be the only option”. Quand on parle généralement d’immortalité de système d’informations, on pense au découplage entre le code et le matériel qui, lui, peut tomber en panne. Si on veut aller plus loin avec l’IA, il faut plutôt se comparer au cerveau qui, lui, est fini, mortel. Si on s’efforce de penser à notre finitude, on obtiendra une gestion plus efficace des ressources. Le lien renforcé entre hardware et software qui s’amorce en ce moment peut donc enfin amener l’IA à être plus efficace du point de vue de nos ressources et donc bien plus puissante.

Pour conclure, Eric Biernat rappelle que les deux premières rencontres entre l’artificiel et le naturel ont tout de même donné des LLMs épatants par leurs résultats, mais parfois angoissants, car peu explicables et très énergivores. Afin de répondre à ces deux problématiques, la vision proposée n’est pas celle de la frugalité, mais plutôt celle de la rencontre entre les écolos et les technophiles. L’IA de demain devra être à la fois plus performante et plus efficace.

Et qu’en est-il de chacun d’entre nous? Nous avons un rôle à jouer vis-à-vis de cette technologie. “Soyons exigeants” : en tant qu’utilisateurs, c’est à nous de guider l’IA vers un développement éthique et durable. Cette révolution est suffisamment bouleversante pour être l’occasion de questionner son usage, de pousser son progrès dans une direction responsable pour la société, et pourquoi pas même de faire le nettoyage dans nos propres processus et organisation pour les rendre plus vertueux. C’est l’occasion de montrer que les fameuses raison d’être, qui ont fleuri un peu partout dans l’entreprise, sont réellement sincères.