Agents IA: Les Nouveaux Maîtres de votre système d’information

Nicolas Cavallo, plante le décor dès le début. En effet, choisir le sujet d’un talk sur l’IA générative plusieurs semaines en avance est une épreuve périlleuse tant le sujet évolue vite.

En Novembre 2023, Bill Gates annonce

“Les Agents IA ne vont pas seulement changer la façon dont chacun interagit avec les ordinateurs. Ils vont également bouleverser l’industrie du logiciel, provoquant la plus grande révolution informatique.” Bill Gates

(la partialité de Bill Gates pouvant être remise en cause de part l’implication de Microsoft dans OpenAI, il n’en demeure pas moins que ses analyses conservent un certain poids.)

C’est de ces fameux agents dont Nicolas nous parle en 3 temps :

- L’historique, qui a permis l’arrivée des Agents

- Comment fonctionnent les agents et qu’est ce qui les caractérise ?

- Les enjeux futurs qui vont guider cette nouvelle ère des systèmes multi agents

Le temps où les modèles ne savaient pas répondre à une question aussi simple pour un humain que “Qui est Nicolas CAVALLO ?” est révolu depuis que nous sommes entrés dans l’ère des agents.

Les prémices des agents:

À la fin des années 50, les réseaux de neurones voient le jour, avec les premières bribes de compréhension de texte par l’IA (perceptron). Cependant le manque de capacités des machines (stockage et puissance) a fortement limité cette expansion, provoquant “un hiver” de l’intelligence artificielle, jusqu’aux alentours de 2012 où deux choses ont changées :

- La digitalisation de la société, nous fournissant une multitude de données

- L’amélioration de nos machines, augmentant la puissance de calcul et les capacités de stockage nous permettant d’exploiter ces données

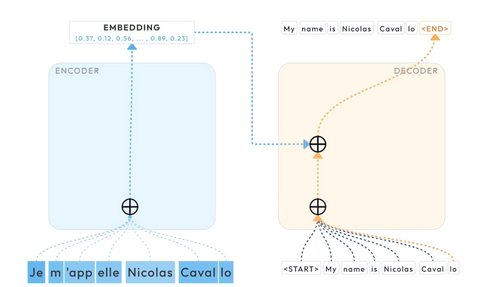

Pour comprendre simplement comment le deep learning traite le texte, il est important d’expliquer le système d’encodeur/ décodeur.

D’un côté, on a une entrée avec du texte (notre prompt) qui passe dans un “encoder”, qui va “résumer” ce contenu dans un vecteur de valeur (ce qu’on appelle un embedding) puis dans un “décodeur”, qui est en charge de générer du contenu de manière itérative.

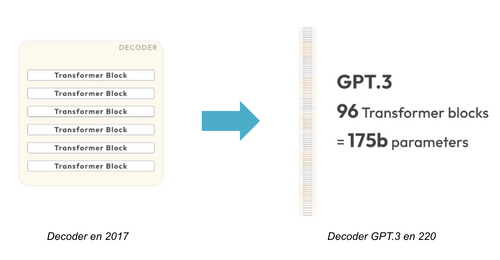

Pour fonctionner, ces deux blocs sont peuplés par ce que l’on appelle des “transformers”: une architecture de réseau de neurones spécialisée pour le traitement de texte, qui a été introduite par Google en 2017.

Pour donner un ordre de grandeur en 2017 pour faire de la traduction un decoder contenait en moyenne 6 blocs de transformer, en 2020 GPT.3 contient 96 blocs de transformer et 175 milliards de paramètres.

C’est à partir de ce moment que l’on a commencé à parler de Large Language Model (LLM) , ces modèles de fondation permettant une grande pertinence dans le traitement du langage. Mais surtout de ce qu’on appelle des “fine-tuned LLM” ou aussi “LLM aligné” qui nous font passer à des modèles entraînés à prédire le mots suivant entraîné à faire des choses simple tel que de la traduction, à des modèles plus spécifiques pouvant suivre des instructions, être aligné avec des valeurs, des façons d’agir.

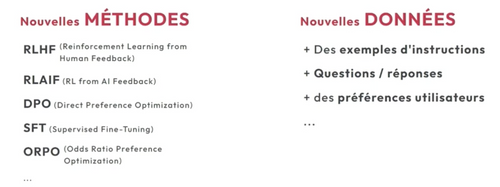

L’alignement se caractérise par deux changements majeurs :

- l'arrivée de nouvelle méthodologie,

- l’utilisation de nouvelles données pour aligner nos modèles avec par exemple des valeurs humaines.

L’utilisation de ces nouvelles données soulève des questions sur les choix d’alignements que l’on souhaite donner à nos modèles: ses préférences utilisateurs, ses valeurs, les questions auxquelles il ne répondra pas etc … Tout cela donne une grande responsabilité au créateur des modèles fine tunés.

Ces modèles alignés permettent aujourd’hui d’ouvrir le champs des possibles quant aux interactions que l’on peut avoir avec eux :

- Communiquer avec eux en langage naturel

- Gérer des conversations (historique)

- Leur donner des rôles ( ex: tu es un coach en développement personnel…)

- Les aider à “raisonner” (ex: “réfléchis” pas à pas)

Cette dernière capacité de “raisonnement” va particulièrement nous intéresser. L’objectif n’est pas de savoir s’ils raisonnent comme des humains, mais d'évaluer leurs capacités à réaliser des tâches qui nécessitent un raisonnement.

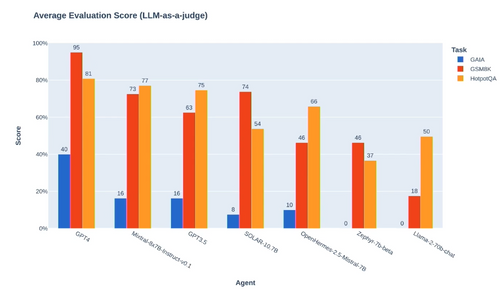

Pour cela, la première étape consiste à définir les tâches de raisonnement qui nous intéressent (mathématiques, logique…) et qui vont permettre à nos modèles d’être opérationnels. Ce seront ces capacités à prendre des décisions et planifier des actions qui vont être cruciales pour les agents et qui vont donc être au cœur des différents benchmarks sur les LLMs.

L’ère des agents :

Un LLM ne suffit pas à définir un agent, les agents se caractérisent par leur capacité à percevoir leurs environnements, on peut leur donner du texte, de l’audio, des images, etc. Ils peuvent exploiter ces inputs pour prendre des décisions, planifier des tâches et répertorier des listes d’actions à accomplir.

Lorsque Nicolas, nous parle de système multi-agents, il fait référence à la capacité des LLMs à communiquer entre eux. Ce type de système n’est clairement pas nouveau, la première définition des Système Multi-Agents (SMA) à vu le jour dans les années 1980. Le vrai changement grâce aux LLMs est que ces échanges se font maintenant de la manière la plus compréhensible qui soit par les humains, car ils utilisent le langage naturel, principalement l’anglais.

Ces agents s'appuient non seulement sur leurs capacités de lecture, comme on peut le voir aujourd’hui dans des architectures RAG permettant d’étendre la base de connaissance d’un modèle à de nouvelles données sans le ré-entraîner. Mais aussi sur leurs capacités à écrire : faire un commit sur git, mettre à jour une base de données, exécuter du code…

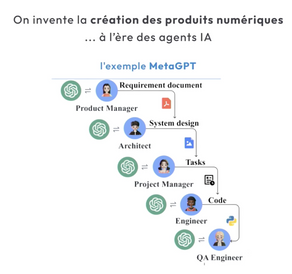

De nombreux cas d’usage naissent de ces nouvelles fonctionnalités, où à la manière d’une véritable équipe projets, les agents peuvent travailler ensemble avec pour chacun d’eux des rôles, des droits et des moyens d’échanges avec les autres. Pour illustrer cela, Nicolas nous cite l’exemple parlant du développement d’une application proposé par META GPT où nous disposons d’une équipe d’agents capables de mener à bien cette mission, avec :

- Un product manager pour définir les besoins fonctionnels et la faisabilité de notre application

- Un architecte pour concevoir techniquement l’application

- Un project manager pour définir les tâches à réaliser

- Un développeur pour coder la solution

- Un testeur pour tester les fonctionnalités développées

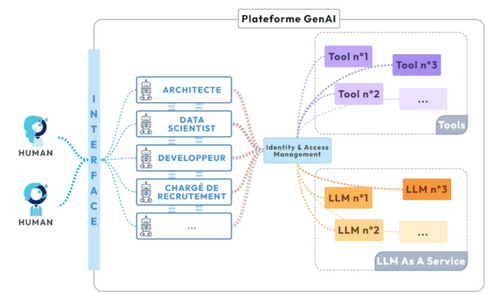

«Ces agents seront à termes intégrés aux SI» et devront être régis au sein d’une plateforme Gen AI, pour laquelle Nicolas nous donne sa vision.

Celle-ci, se caractérisant par :

- Une interface permettant l'interaction entre les humains et les agents

- Les agents, adaptés pour différentes tâches

- D’une liste d’outils et de “LLM as a services” pouvant être utilisés par les agents

- Pour finir, la capacité des agents à communiquer entre eux

En passant par la gestion des droits qui sera un sujet crucial pour maîtriser, fiabiliser et sécuriser ces nouveaux systèmes, car à la question habituelle que l’on se pose dans un système classique, “qui à le droit de faire quoi?” viendra s’ajouter la prise en compte du non-déterminisme des agents.

Des limites en vue d’être dépassées:

Aujourd’hui, l'essor de ces systèmes multi-agents est limité principalement par deux freins:

- Le cout financier

- Le coût environnemental

En effet, les agents sont encore trop énergivores et coûteux pour devenir une norme dès maintenant, cependant leurs coûts ont tendance à diminuer de manière drastique:

Le coût de GPT4 a été divisé par 60 en seulement un an. Cela est donc de bon augure pour anticiper dans un avenir proche une démocratisation de systèmes multi-agents dans nos usages.

Pour finir et boucler avec la citation de Bill Gates évoquée en début d’article, nous reprendrons à nouveau ses mots :

“Dans les cinq prochaines années, il sera impossible de se passer des agents et de les ignorer.” Bill Gates - Nov 2023